[TOC]

JUC高并发编程

1、Java并发知识体系详解

1、知识体系

2、java高并发

2、Java 并发 - 理论基础

从理论的角度引入并发安全问题以及JMM应对并发问题的原理。

1、BAT大厂的面试问题

- 多线程的出现是要解决什么问题的?

- 线程不安全是指什么? 举例说明

- 并发出现线程不安全的本质什么?

- 并发的三要素:可见性,原子性和有序性。

- Java是怎么解决并发问题的?

- 3个关键字,JMM和8个Happens-Before

- 线程安全是不是非真即假?

- 不是

- 线程安全有哪些实现思路?

- 如何理解并发和并行的区别?

2、并发与并行

1、串行模式

串行表示所有任务都按先后顺序进行。

串行意味着必须先装完一车柴才能运送这车柴,只有运送到了,才能卸下这车柴,并且只有完成了这整个三个步骤,才能进行下一个步骤。

串行是一次只能取得一个任务,并执行这个任务。

2、并行模式

并行意味着可以同时取得多个任务,并同时去执行所取得的这些任务。

并行模式相当于将长长的一条队列,划分成了多条短队列,所以并行缩短了任务队列的长度。

并行的效率从代码层次上强依赖于多进程/多线程代码,从硬件角度上则依赖于多核 CPU。

多核 cpu下,每个核(core)都可以调度运行线程,这时候线程可以是并行的。

3、并发

并发(concurrent)指的是多个程序可以同时运行的现象,更细化的是多进程可以同时运行或者多指令可以同时运行。但这不是重点,在描述并发的时候也不会去扣这种字眼是否精确,==并发的重点在于它是一种现象==, ==并发描述的是多进程同时运行的现象==。但实际上,对于单核心 CPU 来说,同一时刻只能运行一个线程,线程实际还是串行执行的。操作系统中有一个组件叫做任务调度器,将 cpu 的时间片(windows下时间片最小约为 15 毫秒)分给不同的程序使用,只是由于 cpu 在线程间(时间片很短)的切换非常快,人类感觉是同时运行的 。所以,这里的”同时运行”表示的不是真的同一时刻有多个线程运行的现象,这是并行的概念,而是提供一种功能让用户看来多个程序同时运行起来了,但实际上这些程序中的进程不是一直霸占 CPU 的,而是执行一会停一会。 总结为一句话就是: ==微观串行,宏观并行== ,一般会将这种 线程轮流使用 CPU 的做法称为并发( concurrent)

要解决大并发问题,通常是将大任务分解成多个小任务,由于操作系统对进程的调度是随机的,所以切分成多个小任务后,可能会从任一小任务处执行。这可能会出现一些现象:

- 可能出现一个小任务执行了多次,还没开始下个任务的情况。这时一般会采用队列或类似的数据结构来存放各个小任务的成果;

- 可能出现还没准备好第一步就执行第二步的可能。这时,一般采用多路复用或异步的方式,比如只有准备好产生了事件通知才执行某个任务;

- 可以多进程/多线程的方式并行执行这些小任务。也可以单进程/单线程执行这些小任务,这时很可能要配合多路复用才能达到较高的效率。

4、并发与并行的区别

并发是指一个处理器同时处理多个任务。并行是指多个处理器或者是多核的处理器同时处理多个不同的任务。并发是逻辑上的同时发生(simultaneous),而并行是物理上的同时发生。

并行(parallel):指在同一时刻,有多条指令在多个处理器上同时执行。就好像两个人各拿一把铁锨在挖坑,一小时后,每人一个大坑。所以无论从微观还是从宏观来看,二者都是一起执行的。

并发(concurrency):指在同一时刻只能有一条指令执行,但多个进程指令被快速的轮换执行,使得在宏观上具有多个进程同时执行的效果,但在微观上并不是同时执行的,只是把时间分成若干段,使多个进程快速交替的执行。这就好像两个人用同一把铁锨,轮流挖坑,一小时后,两个人各挖一个小一点的坑,要想挖两个大一点得坑,一定会用两个小时。

并行在多处理器系统中存在,而并发可以在单处理器和多处理器系统中都存在,并发能够在单处理器系统中存在是因为并发是并行的假象,并行要求程序能够同时执行多个操作,而并发只是要求程序假装同时执行多个操作(每个小时间片执行一个操作,多个操作快速切换执行)。(下图来自Erlang 之父 Joe Armstrong)

当有多个线程在操作时,如果系统只有一个CPU,则它根本不可能真正同时进行一个以上的线程,它只能把CPU运行时间划分成若干个时间段,再将时间段分配给各个线程执行,在一个时间段的线程代码运行时,其它线程处于挂起状态。这种方式我们称之为并发(Concurrent)。

当系统有一个以上CPU时,则线程的操作有可能非并发。当一个CPU执行一个线程时,另一个CPU可以执行另一个线程,两个线程互不抢占CPU资源,可以同时进行,这种方式我们称之为并行(Parallel)。

引用 Rob Pike(golang 语言的创造者) 的一段描述:

- 并发(concurrent)是同一时间应对(dealing with)多件事情的能力

- 并行(parallel)是同一时间动手做(doing)多件事情的能力

- 例子:

- 家庭主妇做饭、打扫卫生、给孩子喂奶,她一个人轮流交替做这多件事,这时就是并发

- 家庭主妇雇了个保姆,她们一起这些事,这时既有并发,也有并行(这时会产生竞争,例如锅只有一口,一个人用锅时,另一个人就得等待)

- 雇了3个保姆,一个专做饭、一个专打扫卫生、一个专喂奶,互不干扰,这时是并行

并发:同一时刻多个线程在访问同一个资源,多个线程对一个点

- 例子:春运抢票 电商秒杀…

并行:多项工作一起执行,之后再汇总

- 例子:泡方便面,电水壶烧水,一边撕调料倒入桶中

5、管程

管程(monitor)是保证了同一时刻只有一个进程在管程内活动,即**管程内定义的操作在同一时刻只被一个进程调用(由编译器实现)**。但是这样并不能保证进程以设计的顺序执行。

JVM 中同步是基于进入和退出管程(monitor)对象实现的,每个对象都会有一个管程(monitor)对象,管程(monitor)会随着 java 对象一同创建和销毁。

执行线程首先要持有管程对象,然后才能执行方法,当方法完成之后会释放管程,方法在执行时候会持有管程,其他线程无法再获取同一个管程。

管程,在java中叫锁,在操作系统中叫监视器,是一种同步机制。

6、用户线程和守护线程

用户线程:平时用到的普通线程、自定义线程

守护线程:运行在后台,是一种特殊的线程。比如垃圾回收线程。

当主线程结束后,用户线程还在运行,JVM 存活;

如果没有用户线程,都是守护线程,JVM 结束 。

可以通过调用

Thread.currentThread().isDaemon()查看当前线程是不是守护线程可以通过调用

当前线程.setDaemon(true)将当前线程设置为守护线程- 这个方法应该在

当前线程.start()执行之前设置

- 这个方法应该在

注意:

- 垃圾回收器线程就是一种守护线程

- Tomcat 中的 Acceptor 和 Poller 线程都是守护线程,所以 Tomcat 接收到 shutdown 命令后,不会等待它们处理完当前请求

3、为什么需要多线程

众所周知,CPU、内存、I/O 设备的速度是有极大差异的,为了合理利用 CPU 的高性能,平衡这三者的速度差异,计算机体系结构、操作系统、编译程序都做出了贡献,主要体现为:

- CPU 增加了缓存,以均衡与内存的速度差异;

- 导致

可见性问题

- 导致

- 操作系统增加了进程、线程,以分时复用 CPU,进而均衡 CPU 与 I/O 设备的速度差异;

- 导致

原子性问题

- 导致

- 编译程序优化指令执行次序,使得缓存能够得到更加合理地利用。

- 导致

有序性问题

- 导致

4、多线程的应用

1、应用之异步调用

1、异步与同步

以调用方角度来讲,如果

- 需要等待结果返回,才能继续运行就是同步

- 不需要等待结果返回,就能继续运行就是异步

2、设计

多线程可以让方法执行变为异步的(即不要巴巴干等着)比如说读取磁盘文件时,假设读取操作花费了 5 秒钟,如果没有线程调度机制,这 5 秒 cpu 什么都做不了,其它代码都得暂停…

3、结论

- 比如在项目中,视频文件需要转换格式等操作比较费时,这时开一个新线程处理视频转换,避免阻塞主线程

- tomcat 的异步 servlet 也是类似的目的,让用户线程处理耗时较长的操作,避免阻塞 tomcat 的工作线程

- ui 程序中,开线程进行其他操作,避免阻塞 ui 线程

2、应用之提高效率

充分利用多核 cpu 的优势,提高运行效率。想象下面的场景,执行 3 个计算,最后将计算结果汇总:

1 | 计算 1 花费 10 ms |

- 如果是串行执行,那么总共花费的时间是 10 + 11 + 9 + 1 = 31ms

- 但如果是四核 cpu,各个核心分别使用线程 1 执行计算 1,线程 2 执行计算 2,线程 3 执行计算 3,那么 3 个线程是并行的,花费时间只取决于最长的那个线程运行的时间,即 11ms 最后加上汇总时间只会花费 12ms

注意:需要在多核 cpu 才能提高效率,单核仍然时是轮流执行

结论

- 单核 cpu 下,多线程不能实际提高程序运行效率,只是为了能够在不同的任务之间切换,不同线程轮流使用cpu ,不至于一个线程总占用 cpu,别的线程没法干活

- 多核 cpu 可以并行跑多个线程,但能否提高程序运行效率还是要分情况的

- 有些任务,经过精心设计,将任务拆分,并行执行,当然可以提高程序的运行效率。但不是所有计算任务都能拆分(参考后文的【阿姆达尔定律】)

- 也不是所有任务都需要拆分,任务的目的如果不同,谈拆分和效率没啥意义

- IO 操作不占用 cpu,只是我们一般拷贝文件使用的是【阻塞 IO】,这时相当于线程虽然不用 cpu,但需要一直等待 IO 结束,没能充分利用线程。所以才有后面的【非阻塞 IO】和【异步 IO】优化

5、线程不安全示例

如果多个线程对同一个共享数据进行访问而不采取同步操作的话,那么操作的结果是不一致的。

以下代码演示了 1000 个线程同时对 cnt 执行自增操作,操作结束之后它的值有可能小于 1000。

1 | public class ThreadUnsafeExample { |

1 | public static void main(String[] args) throws InterruptedException { |

结果:

1 | 997 // 结果总是小于1000 |

6、并发出现问题的根源:并发三要素

上述代码输出的值为什么总是小于1000?并发出现问题的根源是什么?

- 并发的三要素

- 可见性

- 原子性

- 有序性

1、可见性:CPU缓存引起

可见性:一个线程对共享变量的修改,另外一个线程能够立刻看到。

例子:

代码:

1 | //线程1执行的代码 |

假若执行线程1的是CPU1,执行线程2的是CPU2。由上面的分析可知,当线程1执行 i =10这句时,会先把i的初始值加载到CPU1的高速缓存中,然后赋值为10,那么在CPU1的高速缓存当中i的值变为10了,却没有立即写入到主存当中。

此时线程2执行 j = i,它会先去主存读取i的值并加载到CPU2的缓存当中,注意此时内存当中i的值还是0,那么就会使得j的值为0,而不是10。

这就是可见性问题,线程1对变量i修改了之后,线程2没有立即看到线程1修改的值。

2、原子性:分时复用引起

原子性:即一个操作或者多个操作要么全部执行并且执行的过程不会被任何因素打断,要么就都不执行。

经典的银行取钱问题:比如从账户A和账户B同时对一个银行账号取钱1000元,那么必然包括2个操作:

- 从银行账号读取余额,取钱1000元

- 取完钱之后,银行将账号的余额进行更新(-1000)

试想一下,如果这2个操作不具备原子性,会造成什么样的后果。假如从账户A取钱1000元之后,操作突然中止。然后又从B取出了1000元,取出1000元之后,再执行银行余额更新减去1000元的操作。这样就会导致账号减去了1000元,但是账户A与账户B一共取到了2000元。

所以这2个操作必须要具备原子性才能保证不出现一些意外的问题。

3、有序性:重排序引起

有序性:即程序执行的顺序按照代码的先后顺序执行。举个简单的例子,看下面这段代码:

1 | int i = 0; |

上面代码定义了一个int型变量,定义了一个boolean类型变量,然后分别对两个变量进行赋值操作。从代码顺序上看,语句1是在语句2前面的,那么JVM在真正执行这段代码的时候会保证语句1一定会在语句2前面执行吗?

- 不一定,为什么呢?这里可能会发生指令重排序(Instruction Reorder)。

1、CPU的指令重排序

1、名词

Clock Cycle Time:主频的概念大家接触的比较多,而 CPU 的 Clock Cycle Time(时钟周期时间),等于主频的倒数,意思是 CPU 能够识别的最小时间单位,比如说 4G 主频的 CPU 的 Clock Cycle Time 就是 0.25 ns,作为对比,我们墙上挂钟的Cycle Time 是 1s- 例如,运行一条加法指令一般需要一个时钟周期时间

CPI:有的指令需要更多的时钟周期时间,所以引出了 CPI (Cycles Per Instruction)指令平均时钟周期数IPC:IPC(Instruction Per Clock Cycle) 即 CPI 的倒数,表示每个时钟周期能够运行的指令数CPU 执行时间:程序的 CPU 执行时间,即我们前面提到的 user + system 时间,可以用下面的公式来表示- 程序 CPU 执行时间 = 指令数 * CPI * Clock Cycle Time

2、指令重排序优化

事实上,现代处理器会设计为一个时钟周期完成一条执行时间最长的 CPU 指令。为什么这么做呢?

可以想到指令还可以再划分成一个个更小的阶段,例如,每条指令都可以分为:取指令 - 指令译码 - 执行指令 - 内存访问 - 数据写回 这 5 个阶段

术语参考:

- instruction fetch (IF)

- instruction decode (ID)

- execute (EX)

- memory access (MEM)

- register write back (WB)

在不改变程序结果的前提下,这些指令的各个阶段可以通过重排序和组合来实现指令级并行,这一技术在 80’s 中叶到 90’s 中叶占据了计算架构的重要地位。

指令重排的前提是,重排指令不能影响结果,例如:

1 | // 可以重排的例子 |

3、支持流水线的处理器

现代 CPU 支持多级指令流水线,例如支持同时执行 取指令 - 指令译码 - 执行指令 - 内存访问 - 数据写回 的处理器,就可以称之为五级指令流水线。这时 CPU 可以在一个时钟周期内,同时运行五条指令的不同阶段(相当于一条执行时间最长的复杂指令),IPC = 1,本质上,流水线技术并不能缩短单条指令的执行时间,但它变相地提高了指令地吞吐率。

4、SuperScalar 处理器

大多数处理器包含多个执行单元,并不是所有计算功能都集中在一起,可以再细分为整数运算单元、浮点数运算单元等,这样可以把多条指令也可以做到并行获取、译码等,CPU 可以在一个时钟周期内,执行多于一条指令,IPC > 1

2、重排序(Java 内存模型JMM)

1、重排序的分类

在执行程序时为了提高性能,编译器和处理器常常会对指令做重排序。重排序分三种类型:

- 编译器优化的重排序。编译器在不改变单线程程序语义的前提下,可以重新安排语句的执行顺序。

- 指令级并行的重排序。现代处理器采用了指令级并行技术(Instruction-Level Parallelism, ILP)来将多条指令重叠执行。如果不存在数据依赖性,处理器可以改变语句对应机器指令的执行顺序。

- 内存系统的重排序。由于处理器使用缓存和读 / 写缓冲区,这使得加载和存储操作看上去可能是在乱序执行。

从 java 源代码到最终实际执行的指令序列,会分别经历下面三种重排序:

上述的 1 属于编译器重排序,2 和 3 属于处理器重排序。这些重排序都可能会导致多线程程序出现内存可见性问题。对于编译器,JMM 的编译器重排序规则会禁止特定类型的编译器重排序(不是所有的编译器重排序都要禁止)。对于处理器重排序,JMM 的处理器重排序规则会要求 java 编译器在生成指令序列时,插入特定类型的内存屏障(memory barriers,intel 称之为 memory fence)指令,通过内存屏障指令来禁止特定类型的处理器重排序(不是所有的处理器重排序都要禁止)。

JMM 属于语言级的内存模型,它确保在不同的编译器和不同的处理器平台之上,通过禁止特定类型的编译器重排序和处理器重排序,为程序员提供一致的内存可见性保证。

2、处理器重排序与内存屏障指令

现代的处理器使用写缓冲区来临时保存向内存写入的数据。写缓冲区可以保证指令流水线持续运行,它可以避免由于处理器停顿下来等待向内存写入数据而产生的延迟。同时,通过以批处理的方式刷新写缓冲区,以及合并写缓冲区中对同一内存地址的多次写,可以减少对内存总线的占用。虽然写缓冲区有这么多好处,但每个处理器上的写缓冲区,仅仅对它所在的处理器可见。这个特性会对内存操作的执行顺序产生重要的影响:处理器对内存的读 / 写操作的执行顺序,不一定与内存实际发生的读 / 写操作顺序一致!为了具体说明,请看下面示例:

1 | // Processor A |

假设处理器 A 和处理器 B 按程序的顺序并行执行内存访问,最终却可能得到 x = y = 0 的结果。具体的原因如下图所示:

这里处理器 A 和处理器 B 可以同时把共享变量写入自己的写缓冲区(A1,B1),然后从内存中读取另一个共享变量(A2,B2),最后才把自己写缓存区中保存的脏数据刷新到内存中(A3,B3)。当以这种时序执行时,程序就可以得到 x = y = 0 的结果。

从内存操作实际发生的顺序来看,直到处理器 A 执行 A3 来刷新自己的写缓存区,写操作 A1 才算真正执行了。虽然处理器 A 执行内存操作的顺序为:A1->A2,但内存操作实际发生的顺序却是:A2 -> A1。此时,处理器 A 的内存操作顺序被重排序了(处理器 B 的情况和处理器 A 一样,这里就不赘述了)。

这里的关键是,由于写缓冲区仅对自己的处理器可见,它会导致处理器执行内存操作的顺序可能会与内存实际的操作执行顺序不一致。由于现代的处理器都会使用写缓冲区,因此现代的处理器都会允许对写 - 读操做重排序。

下面是常见处理器允许的重排序类型的列表:

| Load-Load | Load-Store | Store-Store | Store-Load | 数据依赖 |

|---|---|---|---|---|

| sparc-TSO | N | N | N | Y |

| x86 | N | N | N | Y |

| ia64 | Y | Y | Y | Y |

| PowerPC | Y | Y | Y | Y |

上表单元格中的“N”表示处理器不允许两个操作重排序,“Y”表示允许重排序。

从上表我们可以看出:常见的处理器都允许 Store-Load 重排序;常见的处理器都不允许对存在数据依赖的操作做重排序。sparc-TSO 和 x86 拥有相对较强的处理器内存模型,它们仅允许对写 - 读操作做重排序(因为它们都使用了写缓冲区)。

- ※注 1:sparc-TSO 是指以 TSO(Total Store Order) 内存模型运行时,sparc 处理器的特性。

- ※注 2:上表中的 x86 包括 x64 及 AMD64。

- ※注 3:由于 ARM 处理器的内存模型与 PowerPC 处理器的内存模型非常类似,本文将忽略它。

- ※注 4:数据依赖性后文会专门说明。

为了保证内存可见性,java 编译器在生成指令序列的适当位置会插入内存屏障指令来禁止特定类型的处理器重排序。JMM 把内存屏障指令分为下列四类:

| 屏障类型 | 指令示例 | 说明 |

|---|---|---|

| LoadLoad Barriers | Load1; LoadLoad; Load2 | 确保 Load1 数据的装载,之前于 Load2 及所有后续装载指令的装载。 |

| StoreStore Barriers | Store1; StoreStore; Store2 | 确保 Store1 数据对其他处理器可见(刷新到内存),之前于 Store2 及所有后续存储指令的存储。 |

| LoadStore Barriers | Load1; LoadStore; Store2 | 确保 Load1 数据装载,之前于 Store2 及所有后续的存储指令刷新到内存。 |

| StoreLoad Barriers | Store1; StoreLoad; Load2 | 确保 Store1 数据对其他处理器变得可见(指刷新到内存),之前于 Load2 及所有后续装载指令的装载。 |

StoreLoad Barriers 会使该屏障之前的所有内存访问指令(存储和装载指令)完成之后,才执行该屏障之后的内存访问指令。

StoreLoad Barriers 是一个“全能型”的屏障,它同时具有其他三个屏障的效果。现代的多处理器大都支持该屏障(其他类型的屏障不一定被所有处理器支持)。执行该屏障开销会很昂贵,因为当前处理器通常要把写缓冲区中的数据全部刷新到内存中(buffer fully flush)。

3、数据依赖性

如果两个操作访问同一个变量,且这两个操作中有一个为写操作,此时这两个操作之间就存在数据依赖性。数据依赖分下列三种类型:

| 名称 | 代码示例 | 说明 |

|---|---|---|

| 写后读 | a = 1;b = a; | 写一个变量之后,再读这个位置。 |

| 写后写 | a = 1;a = 2; | 写一个变量之后,再写这个变量。 |

| 读后写 | a = b;b = 1; | 读一个变量之后,再写这个变量。 |

上面三种情况,只要重排序两个操作的执行顺序,程序的执行结果将会被改变。

前面提到过,编译器和处理器可能会对操作做重排序。编译器和处理器在重排序时,会遵守数据依赖性,编译器和处理器不会改变存在数据依赖关系的两个操作的执行顺序。

注意:

- 这里所说的数据依赖性仅针对单个处理器中执行的指令序列和单个线程中执行的操作,

- 不同处理器之间和不同线程之间的数据依赖性不被编译器和处理器考虑。

4、as-if-serial 语义

as-if-serial 语义的意思指:不管怎么重排序(编译器和处理器为了提高并行度),(单线程)程序的执行结果不能被改变。编译器,runtime 和处理器都必须遵守 as-if-serial 语义。

为了遵守 as-if-serial 语义,编译器和处理器不会对存在数据依赖关系的操作做重排序,因为这种重排序会改变执行结果。但是,如果操作之间不存在数据依赖关系,这些操作可能被编译器和处理器重排序。为了具体说明,请看下面计算圆面积的代码示例:

1 | double pi = 3.14; //A |

上面三个操作的数据依赖关系如下图所示:

如上图所示:

- A 和 C 之间存在数据依赖关系,同时 B 和 C 之间也存在数据依赖关系。

- 因此在最终执行的指令序列中,C 不能被重排序到 A 和 B 的前面(C 排到 A 和 B 的前面,程序的结果将会被改变)。

- 但 A 和 B 之间没有数据依赖关系,编译器和处理器可以重排序 A 和 B 之间的执行顺序。

下图是该程序的两种执行顺序:

as-if-serial 语义把单线程程序保护了起来,遵守 as-if-serial 语义的编译器,runtime 和处理器共同为编写单线程程序的程序员创建了一个幻觉:单线程程序是按程序的顺序来执行的。as-if-serial 语义使单线程程序员无需担心重排序会干扰他们,也无需担心内存可见性问题。

5、程序顺序规则

根据 happens- before 的程序顺序规则,上面计算圆的面积的示例代码存在三个 happens- before 关系:

- A happens- before B;

- B happens- before C;

- A happens- before C;

这里的第 3 个 happens- before 关系,是根据 happens- before 的传递性推导出来的。

这里 A happens- before B,但实际执行时 B 却可以排在 A 之前执行(看上面的重排序后的执行顺序)。如果 A happens- before B,JMM 并不要求 A 一定要在 B 之前执行。JMM 仅仅要求前一个操作(执行的结果)对后一个操作可见,且前一个操作按顺序排在第二个操作之前。这里操作 A 的执行结果不需要对操作 B 可见;而且重排序操作 A 和操作 B 后的执行结果,与操作 A 和操作 B 按 happens- before 顺序执行的结果一致。在这种情况下,JMM 会认为这种重排序并不非法(not illegal),JMM 允许这种重排序。

在计算机中,软件技术和硬件技术有一个共同的目标:在不改变程序执行结果的前提下,尽可能的开发并行度。编译器和处理器遵从这一目标,从 happens- before 的定义我们可以看出,JMM 同样遵从这一目标。

6、重排序对多线程的影响

重排序是否会改变多线程程序的执行结果。请看下面的示例代码:

1 | class ReorderExample { |

flag 变量是个标记,用来标识变量 a 是否已被写入。

这里假设有两个线程 A 和 B,A 首先执行 writer() 方法,随后 B 线程接着执行 reader() 方法。线程 B 在执行操作 4 时,能否看到线程 A 在操作 1 对共享变量 a 的写入?

答案是:不一定能看到。

由于操作 1 和操作 2 没有数据依赖关系,编译器和处理器可以对这两个操作重排序;同样,操作 3 和操作 4 没有数据依赖关系,编译器和处理器也可以对这两个操作重排序。

当操作 1 和操作 2 重排序时,可能会产生什么效果? 请看下面的程序执行时序图:(注:本文统一用红色的虚箭线表示错误的读操作,用绿色的虚箭线表示正确的读操作。)

如上图所示,操作 1 和操作 2 做了重排序。程序执行时,线程 A 首先写标记变量 flag,随后线程 B 读这个变量。由于条件判断为真,线程 B 将读取变量 a。此时,变量 a 还根本没有被线程 A 写入,在这里多线程程序的语义被重排序破坏了!

下面再让我们看看,当操作 3 和操作 4 重排序时会产生什么效果(借助这个重排序,可以顺便说明控制依赖性)。下面是操作 3 和操作 4 重排序后,程序的执行时序图:

在程序中,操作 3 和操作 4 存在控制依赖关系。当代码中存在控制依赖性时,会影响指令序列执行的并行度。为此,编译器和处理器会采用猜测(Speculation)执行来克服控制相关性对并行度的影响。以处理器的猜测执行为例,执行线程 B 的处理器可以提前读取并计算 a*a,然后把计算结果临时保存到一个名为重排序缓冲(reorder buffer ROB)的硬件缓存中。当接下来操作 3 的条件判断为真时,就把该计算结果写入变量 i 中。

从图中我们可以看出,猜测执行实质上对操作 3 和 4 做了重排序。重排序在这里破坏了多线程程序的语义!

结论:

- 在单线程程序中,对存在控制依赖的操作重排序,不会改变执行结果(这也是 as-if-serial 语义允许对存在控制依赖的操作做重排序的原因);

- 但在多线程程序中,对存在控制依赖的操作重排序,可能会改变程序的执行结果。

3、顺序一致性(Java 内存模型JMM)

1、数据竞争与顺序一致性保证

当程序未正确同步时,就会存在数据竞争。java 内存模型规范对数据竞争的定义如下:

- 在一个线程中写一个变量,

- 在另一个线程读同一个变量,

- 而且写和读没有通过同步来排序。

当代码中包含数据竞争时,程序的执行往往产生违反直觉的结果。如果一个多线程程序能正确同步,这个程序将是一个没有数据竞争的程序。

JMM 对正确同步的多线程程序的内存一致性做了如下保证:

- 如果程序是正确同步的,程序的执行将具有顺序一致性(sequentially consistent)

- 即程序的执行结果与该程序在顺序一致性内存模型中的执行结果相同。

- 这里的同步是指广义上的同步,包括对常用同步原语(lock,volatile 和 final)的正确使用。

2、顺序一致性内存模型

顺序一致性内存模型是一个被计算机科学家理想化了的理论参考模型,它为程序员提供了极强的内存可见性保证。顺序一致性内存模型有两大特性:

- 一个线程中的所有操作必须按照程序的顺序来执行。

- (不管程序是否同步)所有线程都只能看到一个单一的操作执行顺序。

在顺序一致性内存模型中,每个操作都必须原子执行且立刻对所有线程可见。 顺序一致性内存模型为程序员提供的视图如下:

在概念上,顺序一致性模型有一个单一的全局内存,这个内存通过一个左右摆动的开关可以连接到任意一个线程。同时,每一个线程必须按程序的顺序来执行内存读 / 写操作。从上图我们可以看出,在任意时间点最多只能有一个线程可以连接到内存。当多个线程并发执行时,图中的开关装置能把所有线程的所有内存读 / 写操作串行化。

为了更好的理解,下面我们通过两个示意图来对顺序一致性模型的特性做进一步的说明。

- 假设有两个线程 A 和 B 并发执行。

- 其中 A 线程有三个操作,它们在程序中的顺序是:A1->A2->A3。

- B 线程也有三个操作,它们在程序中的顺序是:B1->B2->B3。

- 假设这两个线程使用监视器来正确同步:

- A 线程的三个操作执行后释放监视器,

- 随后 B 线程获取同一个监视器。

那么程序在顺序一致性模型中的执行效果将如下图所示:

现在我们再假设这两个线程没有做同步,下面是这个未同步程序在顺序一致性模型中的执行示意图:

未同步程序在顺序一致性模型中虽然整体执行顺序是无序的,但所有线程都只能看到一个一致的整体执行顺序。以上图为例,线程 A 和 B 看到的执行顺序都是:B1->A1->A2->B2->A3->B3。之所以能得到这个保证是因为顺序一致性内存模型中的每个操作必须立即对任意线程可见。

但是,在 JMM 中就没有这个保证。未同步程序在 JMM 中不但整体的执行顺序是无序的,而且所有线程看到的操作执行顺序也可能不一致。比如:在当前线程把写过的数据缓存在本地内存中,且还没有刷新到主内存之前,这个写操作仅对当前线程可见;从其他线程的角度来观察,会认为这个写操作根本还没有被当前线程执行。只有当前线程把本地内存中写过的数据刷新到主内存之后,这个写操作才能对其他线程可见。在这种情况下,当前线程和其它线程看到的操作执行顺序将不一致。

3、同步程序的顺序一致性效果

下面我们对前面的示例程序 ReorderExample 用监视器来同步,看看正确同步的程序如何具有顺序一致性。

代码:

1 | class SynchronizedExample { |

上面示例代码中,假设 A 线程执行 writer() 方法后,B 线程执行 reader() 方法。这是一个正确同步的多线程程序。根据 JMM 规范,该程序的执行结果将与该程序在顺序一致性模型中的执行结果相同。

下面是该程序在两个内存模型中的执行时序对比图:

在顺序一致性模型中,所有操作完全按程序的顺序串行执行。而在 JMM 中,临界区内的代码可以重排序(但 JMM 不允许临界区内的代码“逸出”到临界区之外,那样会破坏监视器的语义)。JMM 会在退出监视器和进入监视器这两个关键时间点做一些特别处理,使得线程在这两个时间点具有与顺序一致性模型相同的内存视图(具体细节后文会说明)。虽然线程 A 在临界区内做了重排序,但由于监视器的互斥执行的特性,这里的线程 B 根本无法“观察”到线程 A 在临界区内的重排序。这种重排序既提高了执行效率,又没有改变程序的执行结果。

从这里我们可以看到 JMM 在具体实现上的基本方针:在不改变(正确同步的)程序执行结果的前提下,尽可能的为编译器和处理器的优化打开方便之门。

4、未同步程序的执行特性

对于未同步或未正确同步的多线程程序,JMM 只提供最小安全性:线程执行时读取到的值,要么是之前某个线程写入的值,要么是默认值(0,null,false),JMM 保证线程读操作读取到的值不会无中生有(out of thin air)的冒出来。

为了实现最小安全性,JVM 在堆上分配对象时,首先会清零内存空间,然后才会在上面分配对象(JVM 内部会同步这两个操作)。因此,在已清零的内存空间(pre-zeroed memory)分配对象时,域的默认初始化已经完成了。

JMM 不保证未同步程序的执行结果与该程序在顺序一致性模型中的执行结果一致。因为未同步程序在顺序一致性模型中执行时,整体上是无序的,其执行结果无法预知。保证未同步程序在两个模型中的执行结果一致毫无意义。

和顺序一致性模型一样,未同步程序在 JMM 中的执行时,整体上也是无序的,其执行结果也无法预知。同时,未同步程序在这两个模型中的执行特性有下面几个差异:

- 顺序一致性模型保证单线程内的操作会按程序的顺序执行,而 JMM 不保证单线程内的操作会按程序的顺序执行(比如上面正确同步的多线程程序在临界区内的重排序)。

- 顺序一致性模型保证所有线程只能看到一致的操作执行顺序,而 JMM 不保证所有线程能看到一致的操作执行顺序。

- JMM 不保证对 64 位的 long 型和 double 型变量的读 / 写操作具有原子性,而顺序一致性模型保证对所有的内存读 / 写操作都具有原子性。

第 3 个差异与处理器总线的工作机制密切相关。在计算机中,数据通过总线在处理器和内存之间传递。每次处理器和内存之间的数据传递都是通过一系列步骤来完成的,这一系列步骤称之为总线事务(bus transaction)。总线事务包括读事务(read transaction)和写事务(write transaction)。读事务从内存传送数据到处理器,写事务从处理器传送数据到内存,每个事务会读 / 写内存中一个或多个物理上连续的字。这里的关键是,总线会同步试图并发使用总线的事务。在一个处理器执行总线事务期间,总线会禁止其它所有的处理器和 I/O 设备执行内存的读 / 写。下面让我们通过一个示意图来说明总线的工作机制:

如上图所示,假设处理器 A,B 和 C 同时向总线发起总线事务,这时总线仲裁(bus arbitration)会对竞争作出裁决,这里我们假设总线在仲裁后判定处理器 A 在竞争中获胜(总线仲裁会确保所有处理器都能公平的访问内存)。此时处理器 A 继续它的总线事务,而其它两个处理器则要等待处理器 A 的总线事务完成后才能开始再次执行内存访问。假设在处理器 A 执行总线事务期间(不管这个总线事务是读事务还是写事务),处理器 D 向总线发起了总线事务,此时处理器 D 的这个请求会被总线禁止。

总线的这些工作机制可以把所有处理器对内存的访问以串行化的方式来执行;在任意时间点,最多只能有一个处理器能访问内存。这个特性确保了单个总线事务之中的内存读 / 写操作具有原子性。

在一些 32 位的处理器上,如果要求对 64 位数据的读 / 写操作具有原子性,会有比较大的开销。为了照顾这种处理器,java 语言规范鼓励但不强求 JVM 对 64 位的 long 型变量和 double 型变量的读 / 写具有原子性。当 JVM 在这种处理器上运行时,会把一个 64 位 long/ double 型变量的读 / 写操作拆分为两个 32 位的读 / 写操作来执行。这两个 32 位的读 / 写操作可能会被分配到不同的总线事务中执行,此时对这个 64 位变量的读 / 写将不具有原子性。

当单个内存操作不具有原子性,将可能会产生意想不到后果。请看下面示意图:

如上图所示,假设处理器 A 写一个 long 型变量,同时处理器 B 要读这个 long 型变量。处理器 A 中 64 位的写操作被拆分为两个 32 位的写操作,且这两个 32 位的写操作被分配到不同的写事务中执行。同时处理器 B 中 64 位的读操作被拆分为两个 32 位的读操作,且这两个 32 位的读操作被分配到同一个的读事务中执行。当处理器 A 和 B 按上图的时序来执行时,处理器 B 将看到仅仅被处理器 A”写了一半”的无效值。

4、总结

1、处理器内存模型

顺序一致性内存模型是一个理论参考模型,JMM 和处理器内存模型在设计时通常会把顺序一致性内存模型作为参照。JMM 和处理器内存模型在设计时会对顺序一致性模型做一些放松,因为如果完全按照顺序一致性模型来实现处理器和 JMM,那么很多的处理器和编译器优化都要被禁止,这对执行性能将会有很大的影响。

根据对不同类型读 / 写操作组合的执行顺序的放松,可以把常见处理器的内存模型划分为下面几种类型:

- 放松了程序中写 - 读操作的顺序,由此产生了 total store ordering 内存模型(简称为 TSO)。

- 在前面 1 的基础上,继续放松程序中写 - 写操作的顺序,由此产生了 partial store order 内存模型(简称为 PSO)。

- 在前面 1 和 2 的基础上,继续放松程序中读 - 写和读 - 读操作的顺序,由此产生了 relaxed memory order 内存模型(简称为 RMO)和 PowerPC 内存模型。

注意:

- 这里处理器对读 / 写操作的放松,是以两个操作之间不存在数据依赖性为前提的(因为处理器要遵守 as-if-serial 语义,处理器不会对存在数据依赖性的两个内存操作做重排序)。

下面的表格展示了常见处理器内存模型的细节特征:

| 内存模型名称 | 对应的处理器 | Store-Load 重排序 | Store-Store 重排序 | Load-Load 和 Load-Store 重排序 | 可以更早读取到其它处理器的写 | 可以更早读取到当前处理器的写 |

|---|---|---|---|---|---|---|

| TSO | sparc-TSO X64 | Y | Y | |||

| PSO | sparc-PSO | Y | Y | Y | ||

| RMO | ia64 | Y | Y | Y | Y | |

| PowerPC | PowerPC | Y | Y | Y | Y | Y |

在这个表格中,我们可以看到所有处理器内存模型都允许写 - 读重排序,原因在前面说明过:它们都使用了写缓存区,写缓存区可能导致写 - 读操作重排序。同时,我们可以看到这些处理器内存模型都允许更早读到当前处理器的写,原因同样是因为写缓存区:由于写缓存区仅对当前处理器可见,这个特性导致当前处理器可以比其他处理器先看到临时保存在自己的写缓存区中的写。

上面表格中的各种处理器内存模型,从上到下,模型由强变弱。越是追求性能的处理器,内存模型设计的会越弱。因为这些处理器希望内存模型对它们的束缚越少越好,这样它们就可以做尽可能多的优化来提高性能。

由于常见的处理器内存模型比 JMM 要弱,java 编译器在生成字节码时,会在执行指令序列的适当位置插入内存屏障来限制处理器的重排序。同时,由于各种处理器内存模型的强弱并不相同,为了在不同的处理器平台向程序员展示一个一致的内存模型,JMM 在不同的处理器中需要插入的内存屏障的数量和种类也不相同。下图展示了 JMM 在不同处理器内存模型中需要插入的内存屏障的示意图:

如上图所示,JMM 屏蔽了不同处理器内存模型的差异,它在不同的处理器平台之上为 java 程序员呈现了一个一致的内存模型。

2、JMM、处理器内存模型与顺序一致性内存模型之间的关系

- JMM 是一个语言级的内存模型

- 处理器内存模型是硬件级的内存模型

- 顺序一致性内存模型是一个理论参考模型。

下面是语言内存模型、处理器内存模型和顺序一致性内存模型的强弱对比示意图:

从上图我们可以看出:

- 常见的 4 种处理器内存模型比常用的 3 中语言内存模型要弱

- 处理器内存模型和语言内存模型都比顺序一致性内存模型要弱。

- 同处理器内存模型一样,越是追求执行性能的语言,内存模型设计的会越弱。

3、JMM 的设计

从 JMM 设计者的角度来说,在设计 JMM 时,需要考虑两个关键因素:

- 程序员对内存模型的使用。程序员希望内存模型易于理解,易于编程。程序员希望基于一个强内存模型来编写代码。

- 编译器和处理器对内存模型的实现。编译器和处理器希望内存模型对它们的束缚越少越好,这样它们就可以做尽可能多的优化来提高性能。编译器和处理器希望实现一个弱内存模型。

由于这两个因素互相矛盾,所以 JSR-133 专家组在设计 JMM 时的核心目标就是找到一个好的平衡点:

- 一方面要**为程序员提供足够强的

内存可见性保证**; - 另一方面,**对编译器和处理器的

限制要尽可能的放松**。

下面让我们看看 JSR-133 是如何实现这一目标的。为了具体说明,请看前面提到过的计算圆面积的示例代码:

1 | double pi = 3.14; //A |

上面计算圆的面积的示例代码存在三个 happens- before 关系:

- A happens- before B;

- B happens- before C;

- A happens- before C;

由于 A happens- before B,happens- before 的定义会要求:

- A 操作执行的结果要对 B 可见,且 A 操作的执行顺序排在 B 操作之前。

- 但是从程序语义的角度来说,对 A 和 B 做重排序即不会改变程序的执行结果,也还能提高程序的执行性能(允许这种重排序减少了对编译器和处理器优化的束缚)。

- 也就是说,上面这 3 个 happens- before 关系中,虽然 2 和 3 是必需要的,但 1 是不必要的。因此,JMM 把 happens- before 要求禁止的重排序分为了下面两类:

- 会改变程序执行结果的重排序。

- 不会改变程序执行结果的重排序。

JMM 对这两种不同性质的重排序,采取了不同的策略:

- 对于会改变程序执行结果的重排序,JMM 要求编译器和处理器必须禁止这种重排序。

- 对于不会改变程序执行结果的重排序,JMM 对编译器和处理器不作要求(JMM 允许这种重排序)。

下面是 JMM 的设计示意图:

从上图可以看出两点:

- JMM 向程序员提供的 happens- before 规则能满足程序员的需求。JMM 的 happens - before 规则不但简单易懂,而且也向程序员提供了足够强的内存可见性保证(有些内存可见性保证其实并不一定真实存在,比如上面的 A happens- before B)。

- JMM 对编译器和处理器的束缚已经尽可能的少。从上面的分析我们可以看出,JMM 其实是在遵循一个基本原则:只要不改变程序的执行结果(指的是单线程程序和正确同步的多线程程序),编译器和处理器怎么优化都行。比如,如果编译器经过细致的分析后,认定一个锁只会被单个线程访问,那么这个锁可以被消除(

锁消除)。再比如,如果编译器经过细致的分析后,认定一个 volatile 变量仅仅只会被单个线程访问,那么编译器可以把这个 volatile 变量当作一个普通变量来对待。这些优化既不会改变程序的执行结果,又能提高程序的执行效率。

4、JMM 的内存可见性保证

Java 程序的内存可见性保证按程序类型可以分为下列三类:

- 单线程程序。单线程程序不会出现内存可见性问题。编译器,runtime 和处理器会共同确保单线程程序的执行结果与该程序在顺序一致性模型中的执行结果相同。

- 正确同步的多线程程序。正确同步的多线程程序的执行将具有顺序一致性(程序的执行结果与该程序在顺序一致性内存模型中的执行结果相同)。这是 JMM 关注的重点,JMM 通过限制编译器和处理器的重排序来为程序员提供内存可见性保证。

- 未同步 / 未正确同步的多线程程序。JMM 为它们提供了最小安全性保障:线程执行时读取到的值,要么是之前某个线程写入的值,要么是默认值(0,null,false)。

下图展示了这三类程序在 JMM 中与在顺序一致性内存模型中的执行结果的异同:

只要多线程程序是正确同步的,JMM 保证该程序在任意的处理器平台上的执行结果,与该程序在顺序一致性内存模型中的执行结果一致。

5、JSR-133 对旧内存模型的修补

JSR-133 对 JDK5 之前的旧内存模型的修补主要有两个:

- 增强 volatile 的内存语义。旧内存模型允许 volatile 变量与普通变量重排序。JSR-133 严格限制 volatile 变量与普通变量的重排序,使 volatile 的写 - 读和锁的释放 - 获取具有相同的内存语义。

- 增强 final 的内存语义。在旧内存模型中,多次读取同一个 final 变量的值可能会不相同。为此,JSR-133 为 final 增加了两个重排序规则。现在,final 具有了初始化安全性。

7、JAVA是怎么解决并发问题的:JMM(Java内存模型)

JMM 即 Java Memory Model,它定义了主存、工作内存抽象概念,底层对应着 CPU 寄存器、缓存、硬件内存、 CPU 指令优化等。

JMM 体现在以下几个方面:

- 原子性 - 保证指令不会受到线程上下文切换的影响

- 可见性 - 保证指令不会受 cpu 缓存的影响

- 有序性 - 保证指令不会受 cpu 指令并行优化的影响

理解的第一个维度:核心知识点

- JMM本质上可以理解为,Java 内存模型规范了 JVM 如何提供按需禁用缓存和编译优化的方法。具体来说,这些方法包括:

volatile、synchronized和final三个关键字Happens-Before规则

- JMM本质上可以理解为,Java 内存模型规范了 JVM 如何提供按需禁用缓存和编译优化的方法。具体来说,这些方法包括:

理解的第二个维度:可见性,有序性,原子性

原子性

在Java中,对基本数据类型的变量的读取和赋值操作是原子性操作,即这些操作是不可被中断的,要么执行,要么不执行。

请分析以下哪些操作是原子性操作:

x = 10; //语句1: 直接将数值10赋值给x,也就是说线程执行这个语句的会直接将数值10写入到工作内存中1

2

3

4

2. ```java

y = x;

//语句2: 包含2个操作,它先要去读取x的值,再将x的值写入工作内存,虽然读取x的值以及将x的值写入工作内存这2个操作都是原子性操作,但是合起来就不是原子性操作了。x++; //语句3: x++包括3个操作:读取x的值,进行加1操作,写入新的值。1

2

3

4. ```java

x = x + 1; //语句4: 同语句3

上面4个语句只有语句1的操作具备原子性。

也就是说,只有简单的读取、赋值(而且必须是将数字赋值给某个变量,变量之间的相互赋值不是原子操作)才是原子操作。

从上面可以看出,Java内存模型只保证了基本读取和赋值是原子性操作,如果要实现更大范围操作的原子性,可以通过

synchronized和Lock来实现。由于synchronized和Lock能够保证任一时刻只有一个线程执行该代码块,那么自然就不存在原子性问题了,从而保证了原子性。

可见性

- Java提供了

volatile关键字来保证可见性。 - 当一个共享变量被volatile修饰时,它会保证修改的值会立即被更新到主存,当有其他线程需要读取时,它会去内存中读取新值。

- 而普通的共享变量不能保证可见性,因为普通共享变量被修改之后,什么时候被写入主存是不确定的,当其他线程去读取时,此时内存中可能还是原来的旧值,因此无法保证可见性。

- 另外,通过

synchronized和Lock也能够保证可见性,synchronized和Lock能保证同一时刻只有一个线程获取锁然后执行同步代码,并且在释放锁之前会将对变量的修改刷新到主存当中。因此可以保证可见性。

- Java提供了

有序性

- 在Java里面,可以通过

volatile关键字来保证一定的”有序性”(具体原理在下面讲述)。另外可以通过synchronized和Lock来保证有序性,很显然,synchronized和Lock保证每个时刻是有一个线程执行同步代码,相当于是让线程顺序执行同步代码,自然就保证了有序性。当然JMM是通过Happens-Before 规则来保证有序性的。

- 在Java里面,可以通过

1、关键字:volatile、synchronized 和 final

1、volatile

2、synchronized

3、final

2、Happens-Before 规则

上面提到了可以用 volatile 和 synchronized 来保证有序性。除此之外,JVM 还规定了先行发生(Happens-Before)原则,让一个操作无需控制就能先于另一个操作完成。

从 JDK5 开始,java 使用新的 JSR-133 内存模型(本文除非特别说明,针对的都是 JSR- 133 内存模型)。JSR-133 提出了 happens-before 的概念,通过这个概念来阐述操作之间的内存可见性。如果一个操作执行的结果需要对另一个操作可见,那么这两个操作之间必须存在 happens-before 关系。这里提到的两个操作既可以是在一个线程之内,也可以是在不同线程之间。 happens-before 规则如下:

- 程序顺序规则:一个线程中的每个操作,happens- before 于该线程中的任意后续操作。

- 监视器锁规则:对一个监视器锁的解锁,happens- before 于随后对这个监视器锁的加锁。

- volatile 变量规则:对一个 volatile 域的写,happens- before 于任意后续对这个 volatile 域的读。

- 传递性:如果 A happens- before B,且 B happens- before C,那么 A happens- before C。

happens-before 规定了对共享变量的写操作对其它线程的读操作可见,它是可见性与有序性的一套规则总结,抛开以下 happens-before 规则,JMM 并不能保证一个线程对共享变量的写,对于其它线程对该共享变量的读可见:(变量都是指成员变量或静态成员变量)

线程解锁 m 之前对变量的写,对于接下来对 m 加锁的其它线程对该变量的读可见

static int x; static Object m = new Object(); new Thread(()->{ synchronized(m) { x = 10; } },"t1").start(); new Thread(()->{ synchronized(m) { System.out.println(x); } },"t2").start();1

2

3

4

5

6

7

8

9

10

11

- 线程对 volatile 变量的写,对接下来其它线程对该变量的读可见

- ```java

volatile static int x;

new Thread(()->{

x = 10;

},"t1").start();

new Thread(()->{

System.out.println(x);

},"t2").start();

线程 start 前对变量的写,对该线程开始后对该变量的读可见

static int x; x = 10; new Thread(()->{ System.out.println(x); },"t2").start();1

2

3

4

5

6

7

8

9

10

11

- 线程结束前对变量的写,对其它线程得知它结束后的读可见(比如其它线程调用 t1.isAlive() 或 t1.join()等待它结束)

- ```java

static int x;

Thread t1 = new Thread(()->{

x = 10;

},"t1");

t1.start();

t1.join();

System.out.println(x);

线程 t1 打断 t2(interrupt)前对变量的写,对于其他线程得知 t2 被打断后对变量的读可见(通过t2.interrupted 或 t2.isInterrupted)

static int x; public static void main(String[] args) { Thread t2 = new Thread(()->{ while(true) { if(Thread.currentThread().isInterrupted()) { System.out.println(x); break; } } },"t2"); t2.start(); new Thread(()->{ sleep(1); x = 10; t2.interrupt(); },"t1").start(); while(!t2.isInterrupted()) { Thread.yield(); } System.out.println(x); }1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

- 对变量默认值(0,false,null)的写,对其它线程对该变量的读可见

- 具有传递性,如果 `x hb-> y` 并且 `y hb-> z` 那么有 `x hb-> z` ,配合 `volatile` 的防指令重排,有下面的例子

- ```java

volatile static int x;

static int y;

new Thread(()->{

y = 10;

x = 20;

},"t1").start();

new Thread(()->{

// x=20 对 t2 可见, 同时 y=10 也对 t2 可见

System.out.println(x);

},"t2").start();

注意:

- 两个操作之间具有 happens-before 关系,并不意味着前一个操作必须要在后一个操作之前执行!

- happens-before 仅仅要求前一个操作(执行的结果)对后一个操作可见,且前一个操作按顺序排在第二个操作之前(the first is visible to and ordered before the second)。

happens-before 与 JMM 的关系如下图所示:

如上图所示,一个 happens-before 规则通常对应于多个编译器重排序规则和处理器重排序规则。对于 java 程序员来说,happens-before 规则简单易懂,它避免程序员为了理解 JMM 提供的内存可见性保证而去学习复杂的重排序规则以及这些规则的具体实现。

1、单一线程原则(Single Thread rule)

在一个线程内,在程序前面的操作先行发生于后面的操作。

2、管程锁定规则(Monitor Lock Rule)

一个 unlock 操作先行发生于后面对同一个锁的 lock 操作。

3、volatile 变量规则(Volatile Variable Rule)

对一个 volatile 变量的写操作先行发生于后面对这个变量的读操作。

4、线程启动规则(Thread Start Rule)

Thread 对象的 start() 方法调用先行发生于此线程的每一个动作。

5、线程加入规则(Thread Join Rule)

Thread 对象的结束先行发生于 join() 方法返回。

6、线程中断规则(Thread Interruption Rule)

对线程 interrupt() 方法的调用先行发生于被中断线程的代码检测到中断事件的发生,可以通过 interrupted() 方法检测到是否有中断发生。

7、对象终结规则(Finalizer Rule)

一个对象的初始化完成(构造函数执行结束)先行发生于它的 finalize() 方法的开始。

8、传递性(Transitivity)

如果操作 A 先行发生于操作 B,操作 B 先行发生于操作 C,那么操作 A 先行发生于操作 C。

8、线程安全:不是一个非真即假的命题

一个类在可以被多个线程安全调用时就是线程安全的。

线程安全不是一个非真即假的命题,可以将共享数据按照安全程度的强弱顺序分成以下五类:

- 不可变

- 绝对线程安全

- 相对线程安全

- 线程兼容

- 线程对立。

1、不可变(Immutable)

不可变(Immutable)的对象一定是线程安全的,不需要再采取任何的线程安全保障措施。只要一个不可变的对象被正确地构建出来,永远也不会看到它在多个线程之中处于不一致的状态。

多线程环境下,应当尽量使对象成为不可变,来满足线程安全。

不可变的类型:

final 关键字修饰的基本数据类型

String

枚举类型

Number 部分子类,如 Long 和 Double 等数值包装类型,BigInteger 和 BigDecimal 等大数据类型。

- 但同为 Number 的原子类 AtomicInteger 和 AtomicLong 则是可变的。

日期格式转换类

DateTimeFormatter平常用的的日期格式转换类

SimpleDateFormat在多线程下是不安全的,有很大几率出现java.lang.NumberFormatException或者出现不正确的日期解析结果在 Java 8 后通过了

DateTimeFormatter解决这个问题,在文档中你可以发现对DateTimeFormatter的描述:1

2

This class is immutable and thread-safe.

对于集合类型,可以使用 Collections.unmodifiableXXX() 方法来获取一个不可变的集合。

Collections.unmodifiableXXX() 先对原始的集合进行拷贝,需要对集合进行修改的方法都直接抛出异常。

1 | public class ImmutableExample { |

1 | public V put(K key, V value) { |

1 | Exception in thread "main" java.lang.UnsupportedOperationException |

1、不可变的设计要素

以String为例,说明一下不可变设计的要素:

1 | public final class String |

String整一个类被final修饰了,保证了String没有任何子类,所以也不用担心子类去修改重写它的方法而导致破坏不可变性- hash虽然没有加上什么final修饰,但是hash是私有的并且String类没有提供hash的set方法,外部没有办法修改hash的值,所以也算保证了hash的不可变性

- char[]数组使用了

final修饰,在构造方法当中赋值,保证了value值的不可变性; - 但是这样只是保证了char[]数组这个引用变量的不可变性,怎么保证char[]数组里面的值具有不可变性呢?

- 主要是依赖了String的构造方法。

String的构造方法:

1 | // 无参 |

2、保护性拷贝(defensive copy)

使用字符串时,也有一些跟修改相关的方法啊,比如 substring 等,那不就破坏了String的不可变性了吗?那么下面就看一看这些方法是如何实现的,就以 substring 为例:

1 | public String substring(int beginIndex) { |

发现其内部是调用 String 的构造方法创建了一个新字符串,再进入这个构造看看,是否对 final char[] value 做出了修改:

1 | public String(char value[], int offset, int count) { |

结果发现也没有,构造新字符串对象时,会生成新的 char[] value,对内容进行复制 。这种通过创建副本对象来避免共享的手段称之为【保护性拷贝(defensive copy)】

2、绝对线程安全

不管运行时环境如何,调用者都不需要任何额外的同步措施。

3、相对线程安全

相对线程安全需要保证对这个对象单独的操作是线程安全的,在调用的时候不需要做额外的保障措施。但是对于一些特定顺序的连续调用,就可能需要在调用端使用额外的同步手段来保证调用的正确性。

在 Java 语言中,大部分的线程安全类都属于这种类型,例如 Vector、HashTable、Collections 的 synchronizedCollection() 方法包装的集合等。

对于下面的代码,如果删除元素的线程删除了 Vector 的一个元素,而获取元素的线程试图访问一个已经被删除的元素,那么就会抛出 ArrayIndexOutOfBoundsException。

1 | public class VectorUnsafeExample { |

1 | Exception in thread "Thread-159738" java.lang.ArrayIndexOutOfBoundsException: Array index out of range: 3 |

如果要保证上面的代码能正确执行下去,就需要对删除元素和获取元素的代码进行同步。

1 | executorService.execute(() -> { |

4、线程兼容

线程兼容是指对象本身并不是线程安全的,但是可以通过在调用端正确地使用同步手段来保证对象在并发环境中可以安全地使用,我们平常说一个类不是线程安全的,绝大多数时候指的是这一种情况。Java API 中大部分的类都是属于线程兼容的,如与前面的 Vector 和 HashTable 相对应的集合类 ArrayList 和 HashMap 等。

5、线程对立

线程对立是指无论调用端是否采取了同步措施,都无法在多线程环境中并发使用的代码。由于 Java 语言天生就具备多线程特性,线程对立这种排斥多线程的代码是很少出现的,而且通常都是有害的,应当尽量避免。

9、线程安全的实现方法

1、互斥同步

synchronized 和 ReentrantLock。

2、非阻塞同步

互斥同步最主要的问题就是线程阻塞和唤醒所带来的性能问题,因此这种同步也称为阻塞同步。

互斥同步属于一种悲观的并发策略,总是认为只要不去做正确的同步措施,那就肯定会出现问题。无论共享数据是否真的会出现竞争,它都要进行加锁(这里讨论的是概念模型,实际上虚拟机会优化掉很大一部分不必要的加锁)、用户态核心态转换、维护锁计数器和检查是否有被阻塞的线程需要唤醒等操作。

1、CAS(JUC中CAS, Unsafe和原子类相关)

随着硬件指令集的发展,我们可以使用基于冲突检测的乐观并发策略:==先进行操作==**,如果没有其它线程争用共享数据,那操作就成功了,否则采取补偿措施(不断地重试,直到成功为止)**。这种乐观的并发策略的许多实现都不需要将线程阻塞,因此这种同步操作称为非阻塞同步。

乐观锁需要==操作和冲突检测这两个步骤具备原子性==,这里就不能再使用互斥同步来保证了,只能靠硬件来完成。硬件支持的原子性操作最典型的是:**比较并交换(Compare-and-Swap,CAS)**。

CAS 指令需要有 3 个操作数,分别是:

- 内存地址 V

- 旧的预期值 A

- 新值 B。

当执行操作时,只有当 V 的值等于 A,才将 V 的值更新为 B。(否则一直循环重试,直到成功为止)

2、AtomicInteger

J.U.C 包里面的整数原子类 AtomicInteger,其中的 compareAndSet() 和 getAndIncrement() 等方法都使用了 Unsafe 类的 CAS 操作。

以下代码使用了 AtomicInteger 执行了自增的操作:

1 | private AtomicInteger cnt = new AtomicInteger(); |

以下代码是 incrementAndGet() 的源码,它调用了 unsafe 的 getAndAddInt()

1 | public final int incrementAndGet() { |

以下代码是 getAndAddInt() 源码,其中:

- var1 指示对象内存地址;

- var2 指示该字段相对对象内存地址的偏移;

- var4 指示操作需要加的数值,这里为 1。

具体过程:

- 通过 getIntVolatile(var1, var2) 得到旧的预期值;

- 通过调用 compareAndSwapInt() 来进行 CAS 比较,如果该字段内存地址中的值等于 var5,那么就更新内存地址为 var1+var2 的变量为 var5+var4。

- 可以看到 getAndAddInt() 在一个循环中进行,发生冲突的做法是不断的进行重试。

1 | public final int getAndAddInt(Object var1, long var2, int var4) { |

3、ABA

ABA问题:如果一个变量初次读取的时候是 A 值,它的值被改成了 B,后来又被改回为 A,那 CAS 操作就会误认为它从来没有被改变过。

J.U.C 包提供了一个带有标记的原子引用类 AtomicStampedReference 来解决这个问题,它可以通过控制变量值的版本来保证 CAS 的正确性。大部分情况下 ABA 问题不会影响程序并发的正确性,如果需要解决 ABA 问题,改用传统的互斥同步可能会比原子类更高效。

3、无同步方案

要保证线程安全,并不是一定就要进行同步。如果一个方法本来就不涉及共享数据,那它自然就无须任何同步措施去保证正确性。

1、栈封闭(JUC中线程池相关)

多个线程访问同一个方法的==局部变量==时,不会出现线程安全问题,因为局部变量存储在虚拟机栈中,属于线程私有的。

1 | import java.util.concurrent.ExecutorService; |

1 | public static void main(String[] args) { |

1 | 100 |

2、线程本地存储(Thread Local Storage)(JUC中ThreadLocal详解)

如果一段代码中所需要的数据必须与其他代码共享,那就看看这些共享数据的代码是否能保证在同一个线程中执行。如果能保证,我们就可以把共享数据的可见范围限制在同一个线程之内,这样,无须同步也能保证线程之间不出现数据争用的问题。

符合这种特点的应用并不少见,大部分使用消费队列的架构模式(如“生产者-消费者”模式)都会将产品的消费过程尽量在一个线程中消费完。其中最重要的一个应用实例就是经典 Web 交互模型中的“==一个请求对应一个服务器线程”(Thread-per-Request)==的处理方式,这种处理方式的广泛应用使得很多 Web 服务端应用都可以使用线程本地存储来解决线程安全问题。

可以使用 ==java.lang.ThreadLocal== 类来实现线程本地存储功能。

对于以下代码,thread1 中设置 threadLocal 为 1,而 thread2 设置 threadLocal 为 2。过了一段时间之后,thread1 读取 threadLocal 依然是 1,不受 thread2 的影响。

1 | public class ThreadLocalExample { |

输出结果:1

为了理解 ThreadLocal,先看以下代码:

1 | public class ThreadLocalExample1 { |

它所对应的底层结构图为:

每个 Thread 都有一个 ==ThreadLocal.ThreadLocalMap 对象==,Thread 类中就定义了 ThreadLocal.ThreadLocalMap 成员。

1 | /* ThreadLocal values pertaining to this thread. This map is maintained |

当调用一个 ThreadLocal 的 set(T value) 方法时,先得到当前线程的 ThreadLocalMap 对象,然后将 ThreadLoca -> value 键值对插入到该 Map 中。

1 | public void set(T value) { |

get() 方法类似:

1 | public T get() { |

hreadLocal 从理论上讲并不是用来解决多线程并发问题的,因为根本不存在多线程竞争。

注意:

- **在一些场景 (尤其是使用线程池) 下,由于 ThreadLocal.ThreadLocalMap 的底层数据结构导致 ==ThreadLocal 有内存泄漏的情况==**;

- 应该尽可能在每次使用 ThreadLocal 后==手动调用 remove()==,以==避免出现 ThreadLocal 经典的内存泄漏==甚至是造成自身业务混乱的风险。

3、可重入代码(Reentrant Code)

这种代码也叫做纯代码(Pure Code),可以在代码执行的任何时刻中断它,转而去执行另外一段代码(包括递归调用它本身),而在控制权返回后,原来的程序不会出现任何错误。

可重入代码有一些共同的特征:

- 例如不依赖存储在堆上的数据和公用的系统资源;

- 用到的状态量都由参数中传入

- 不调用非可重入的方法等。

4、无状态

在 web 阶段学习时,设计 Servlet 时为了保证其线程安全,都会有这样的建议,不要为 Servlet 设置成员变量,这种没有任何成员变量的类是线程安全的

因为成员变量保存的数据也可以称为状态信息,因此没有成员变量就称之为【无状态】

3、Java 并发 - 线程基础

1、BAT大厂的面试问题

- 线程有哪几种状态?分别说明从一种状态到另一种状态转变有哪些方式?

- 通常线程有哪几种使用方式?

- 基础线程机制有哪些?

- 线程的中断方式有哪些?

- 线程的互斥同步方式有哪些?如何比较和选择?

- 线程之间有哪些协作方式?

2、进程与线程

1、进程

进程(Process) 是计算机中的程序关于某数据集合上的一次运行活动,是系统进行资源分配和调度的基本单位,是操作系统结构的基础。

在当代面向线程设计的计算机结构中,进程是线程的容器。

进程:

- 是程序的实体;

- 是计算机中的程序关于某数据集合上的一次运行活动;

- 是系统进行资源分配和调度的基本单位;

- 是操作系统结构的基础。

- 程序是指令、数据及其组织形式的描述,进程是程序的实体。

进程:

- 程序由指令和数据组成,但这些指令要运行,数据要读写,就必须将指令加载至 CPU,数据加载至内存。在指令运行过程中还需要用到磁盘、网络等设备。进程就是用来加载指令、管理内存、管理 IO 的

- 当一个程序被运行,从磁盘加载这个程序的代码至内存,这时就开启了一个进程。

- 进程就可以视为程序的一个实例。大部分程序可以同时运行多个实例进程(例如记事本、画图、浏览器

等),也有的程序只能启动一个实例进程(例如网易云音乐、360 安全卫士等)

2、线程

线程(thread) 是操作系统能够进行运算调度的最小单位。它被包含在进程之中,是进程中的实际运作单位。一条线程指的是进程中一个单一顺序的控制流,一个进程中可以并发多个线程,每条线程并行执行不同的任务。

线程:

- 一个进程之内可以分为一到多个线程。

- 一个线程就是一个指令流,将指令流中的一条条指令以一定的顺序交给 CPU 执行

- Java 中,线程作为最小调度单位,进程作为资源分配的最小单位。 在 windows 中进程是不活动的,只是作为线程的容器

3、进程与线程的区别

- 进程:指在系统中正在运行的一个应用程序;程序一旦运行就是进程;

- 进程——资源分配的最小单位。

- 线程:系统分配处理器时间资源的基本单元,或者说进程之内独立执行的一个单元执行流。

- 线程——程序执行的最小单位。

- 进程基本上相互独立的,而线程存在于进程内,是进程的一个子集

- 进程拥有共享的资源,如内存空间等,供其内部的线程共享

- 进程间通信较为复杂

- 同一台计算机的进程通信称为 IPC(Inter-process communication)

- 信号量:信号量是一个计数器,用于多进程对共享数据的访问,解决同步相关的问题并避免竞争条件

- 共享存储:多个进程可以访问同一块内存空间,需要使用信号量用来同步对共享存储的访问

- 管道通信:管道是用于连接一个读进程和一个写进程以实现它们之间通信的一个共享文件,pipe文件

- 匿名管道(Pipes) :用于具有亲缘关系的父子进程间或者兄弟进程之间的通信,只支持半双工通信

- 命名管道(Names Pipes):以磁盘文件的方式存在,可以实现本机任意两个进程通信,遵循FIFO

- 消息队列:内核中存储消息的链表,由消息队列标识符标识,能在不同进程之间提供全双工通信,对比管道:

- 匿名管道存在于内存中的文件;命名管道存在于实际的磁盘介质或者文件系统;消息队列存放在内核中,只有在内核重启(操作系统重启)或者显示地删除一个消息队列时,该消息队列才被真正删除

- 读进程可以根据消息类型有选择地接收消息,而不像 FIFO 那样只能默认地接收

- 不同计算机之间的进程通信,需要通过网络,并遵守共同的协议,例如 HTTP

- 套接字:与其它通信机制不同的是,它可用于不同机器间的进程通信

- 同一台计算机的进程通信称为 IPC(Inter-process communication)

- 线程通信相对简单,因为它们共享进程内的内存,一个例子是多个线程可以访问同一个共享变量

- Java中的通信机制:volatile、等待/通知机制、join方式、InheritableThreadLocal、MappedByteBuffer

- 线程更轻量,线程上下文切换成本一般上要比进程上下文切换低

3、线程状态转换

1、线程的五状态模型(操作系统)

- 【初始状态】仅是在语言层面创建了线程对象,还未与操作系统线程关联

- 【可运行状态】(就绪状态)指该线程已经被创建(与操作系统线程关联),可以由 CPU 调度执行

- 【运行状态】指获取了 CPU 时间片运行中的状态

- 当 CPU 时间片用完,会从【运行状态】转换至【可运行状态】,会导致线程的上下文切换

- 【阻塞状态】

- 如果调用了阻塞 API,如 BIO 读写文件,这时该线程实际不会用到 CPU,会导致线程上下文切换,进入【阻塞状态】

- 等 BIO 操作完毕,会由操作系统唤醒阻塞的线程,转换至【可运行状态】

- 与【可运行状态】的区别是,对【阻塞状态】的线程来说只要它们一直不唤醒,调度器就一直不会考虑调度它们

- 【终止状态】表示线程已经执行完毕,生命周期已经结束,不会再转换为其它状态

2、线程的七状态模型(操作系统)

3、线程的六状态模型(java)

这是从 Java API 层面来描述的

根据 Thread.State 枚举,分为六种状态:

NEW线程刚被创建,但是还没有调用 start() 方法RUNNABLE当调用了 start() 方法之后,注意,Java API 层面的 RUNNABLE 状态涵盖了 操作系统 层面的【==可运行状态==】、【==运行状态==】和【==阻塞状态==】(由于 BIO 导致的线程阻塞,在 Java 里无法区分,仍然认为是可运行)BLOCKED,WAITING,TIMED_WAITING都是 Java API 层面对【阻塞状态】的细分,后面会在状态转换一节详述TERMINATED当线程代码运行结束

假设有线程 Thread t

- NEW –> RUNNABLE

- 当调用

t.start()方法时,由NEW --> RUNNABLE

- 当调用

- RUNNABLE <–> WAITING

- t 线程用 synchronized(obj) 获取了对象锁后

- 调用

obj.wait()方法时,t 线程从RUNNABLE --> WAITING - 调用

obj.notify(),obj.notifyAll(),t.interrupt()时- 线程被notify之后直接从waitset进入entrylist,对应的状态就是

WAITING --> BLOCKED - 等到锁释放之后,t线程进入锁的竞争

- 竞争锁成功,t 线程从

WAITING --> RUNNABLE - 竞争锁失败,t 线程从

WAITING --> BLOCKED

- 竞争锁成功,t 线程从

- 线程被notify之后直接从waitset进入entrylist,对应的状态就是

- 调用

- t 线程用 synchronized(obj) 获取了对象锁后

- RUNNABLE <–> WAITING

- 当前线程调用

t.join()方法时,当前线程从RUNNABLE --> WAITING- 注意是当前线程在t 线程对象的监视器上等待

- t 线程运行结束,或调用了当前线程的

interrupt()时,当前线程从WAITING --> RUNNABLE

- 当前线程调用

- RUNNABLE <–> WAITING

- 当前线程调用

LockSupport.park()方法会让当前线程从RUNNABLE --> WAITING - 调用

LockSupport.unpark(目标线程)或调用了线程 的interrupt(),会让目标线程从WAITING --> RUNNABLE

- 当前线程调用

- RUNNABLE <–> TIMED_WAITING

- t 线程用 synchronized(obj) 获取了对象锁后

- 调用

obj.wait(long n)方法时,t 线程从RUNNABLE --> TIMED_WAITING - t 线程等待时间超过了 n 毫秒,或调用

obj.notify(),obj.notifyAll(),t.interrupt()时- 线程被notify之后直接从waitset进入entrylist,对应的状态就是

WAITING --> BLOCKED - 等到锁释放之后,t线程进入锁的竞争

- 竞争锁成功,t 线程从

TIMED_WAITING --> RUNNABLE - 竞争锁失败,t 线程从

TIMED_WAITING --> BLOCKED

- 竞争锁成功,t 线程从

- 线程被notify之后直接从waitset进入entrylist,对应的状态就是

- 调用

- t 线程用 synchronized(obj) 获取了对象锁后

- RUNNABLE <–> TIMED_WAITING

- 当前线程调用

t.join(long n)方法时,当前线程从RUNNABLE --> TIMED_WAITING- 注意是当前线程在t 线程对象的监视器上等待

- 当前线程等待时间超过了 n 毫秒,或t 线程运行结束,或调用了当前线程的

interrupt()时,当前线程从TIMED_WAITING --> RUNNABLE

- 当前线程调用

- RUNNABLE <–> TIMED_WAITING

- 当前线程调用

Thread.sleep(long n),当前线程从RUNNABLE --> TIMED_WAITING - 当前线程等待时间超过了 n 毫秒,当前线程从

TIMED_WAITING --> RUNNABLE

- 当前线程调用

- RUNNABLE <–> TIMED_WAITING

- 当前线程调用

LockSupport.parkNanos(long nanos)或LockSupport.parkUntil(long millis)时,当前线程从RUNNABLE --> TIMED_WAITING - 调用

LockSupport.unpark(目标线程)或调用了线程 的interrupt(),或是等待超时,会让目标线程从TIMED_WAITING--> RUNNABLE

- 当前线程调用

- RUNNABLE <–> BLOCKED

- t 线程用 synchronized(obj) 获取了对象锁时如果竞争失败,从

RUNNABLE --> BLOCKED - 持 obj 锁线程的同步代码块执行完毕,会唤醒该对象上所有

BLOCKED的线程重新竞争,如果其中 t 线程竞争成功,从BLOCKED --> RUNNABLE,其它失败的线程仍然BLOCKED

- t 线程用 synchronized(obj) 获取了对象锁时如果竞争失败,从

- RUNNABLE <–> TERMINATED

- 当前线程所有代码运行完毕,进入

TERMINATED

- 当前线程所有代码运行完毕,进入

线程一共有六种状态:

- 新建(new)

- 可运行(runnable)

- 阻塞(blocking)

- 无限期等待(waiting)

- 限期等待(timed waiting)

- 死亡(terminated)

1、新建(New)

创建后尚未启动。

2、可运行(Runnable)

可能正在运行,也可能正在等待 CPU 时间片。

包含了操作系统线程状态中的 Running 和 Ready。

3、阻塞(Blocking)

等待获取一个排它锁,如果其线程释放了锁就会结束此状态。

4、无限期等待(Waiting)

等待其它线程显式地唤醒,否则不会被分配 CPU 时间片。

| 进入方法 | 退出方法 |

|---|---|

| 没有设置 Timeout 参数的 Object.wait() 方法 | Object.notify() / Object.notifyAll() |

| 没有设置 Timeout 参数的 Thread.join() 方法 | 被调用的线程执行完毕 |

| LockSupport.park() 方法 | - |

5、限期等待(Timed Waiting)

无需等待其它线程显式地唤醒,在一定时间之后会被系统自动唤醒。

- 调用 Thread.sleep() 方法使线程进入限期等待状态时,常常用“使一个线程睡眠”进行描述。

- 调用 Object.wait() 方法使线程进入限期等待或者无限期等待时,常常用“挂起一个线程”进行描述。

睡眠和挂起是用来描述行为,而阻塞和等待用来描述状态。

阻塞和等待的区别:

- 阻塞是被动的,它是在等待获取一个排它锁。

- 而等待是主动的,通过调用 Thread.sleep() 和 Object.wait() 等方法进入。

| 进入方法 | 退出方法 |

|---|---|

| Thread.sleep() 方法 | 时间结束 |

| 设置了 Timeout 参数的 Object.wait() 方法 | 时间结束 / Object.notify() / Object.notifyAll() |

| 设置了 Timeout 参数的 Thread.join() 方法 | 时间结束 / 被调用的线程执行完毕 |

| LockSupport.parkNanos() 方法 | - |

| LockSupport.parkUntil() 方法 | - |

6、死亡(Terminated)

可以是线程结束任务之后自己结束,或者产生了异常而结束。

4、线程的四种使用方式

有三种使用线程的方法:

- 实现 Runnable 接口;

- 实现 Callable 接口;

- 继承 Thread 类;

- 使用线程池

实现 Runnable 和 Callable 接口的类只能当做一个可以在线程中运行的任务,不是真正意义上的线程,因此最后还需要通过 Thread 来调用。可以说任务是通过线程驱动从而执行的。

1、实现 Runnable 接口

- 编写需要的类并实现Runnable接口,实现里面的 run() 方法。

- 通过 Thread 调用 start() 方法来启动线程。

代码:

1 | public class MyRunnable implements Runnable { |

1 | public static void main(String[] args) { |

实现 Runnable 接口的优缺点:

- 缺点:代码复杂一点。

- 优点:

- 线程任务类只是实现了Runnable接口,可以继续继承其他类,避免了单继承的局限性

- 同一个线程任务对象可以被包装成多个线程对象

- 适合多个多个线程去共享同一个资源

- 实现解耦操作,线程任务代码可以被多个线程共享,线程任务代码和线程独立

- 线程池可以放入实现Runnable或Callable线程任务对象

2、实现 Callable 接口

与Runnable 接口大致相同:

- 编写需要的类并实现Callable接口,实现里面的 call() 方法,该方法有返回值。

- 通过 Thread 调用 start() 方法来启动线程。

区别是:与 Runnable 相比,Callable 可以有返回值,返回值通过 FutureTask 进行封装。

1 | public class MyCallable implements Callable<Integer> { |

1 | public static void main(String[] args) throws ExecutionException, InterruptedException { |

实现 Callable 接口的优缺点:

- 优点:同 Runnable,并且能得到线程执行的结果

- 缺点:编码复杂

3、继承 Thread 类

同样也是需要实现 run() 方法,因为 Thread 类也实现了 Runable 接口。

当调用 start() 方法启动一个线程时,虚拟机会将该线程放入就绪队列中等待被调度,当一个线程被调度时会执行该线程的 run() 方法。

建议线程先创建子线程,主线程的任务放在之后,否则主线程(main)永远是先执行完

1 | public class MyThread extends Thread { |

1 | public static void main(String[] args) { |

继承 Thread 类的优缺点:

- 优点:编码简单

- 缺点:线程类已经继承了Thread类无法继承其他类了,功能不能通过继承拓展(单继承的局限性)

4、使用线程池

Java标准库提供了ExecutorService接口表示线程池,因为ExecutorService只是接口,Java标准库提供的几个常用实现类有:

- FixedThreadPool:线程数固定的线程池;

- CachedThreadPool:线程数根据任务动态调整的线程池;

- SingleThreadExecutor:仅单线程执行的线程池。

创建这些线程池的方法都被封装到Executors这个类中。

1 | import java.util.concurrent.*; |

线程池的具体细节放在下面线程池篇具体说明

5、Thread 与 Runnable 的底层关系

使用Runnable的方法创建线程的代码:

1 | Thread t = new Thread(()->{ log.debug("running"); }, "t2"); |

Thread底层代码:

1 | // Thread的一个构造函数 |

总结:

- Thread类本身实现了Runnable接口

- 如果直接使用Thread的方式创建线程对象,则原理是重写了Thread的run方法

- 如果使用的Runnable的方式创建线程对象,在原理是将Runnable对象封装成target,在Thread中调用target.run方法

6、实现接口 VS 继承 Thread

实现接口会更好一些,因为:

- 使用接口更容易与线程池等高级 API 配合

- 使用接口让任务类脱离了 Thread 继承体系,更灵活

- Java 不支持多重继承,因此继承了 Thread 类就无法继承其它类,但是可以实现多个接口;

- 类可能只要求可执行就行,继承整个 Thread 类开销过大。

7、调用start()方法,线程是否会马上创建?

- 线程不一定马上创建的

- 看start()方法的源码知道start()方法底层调用了start0()方法,这是一个被

native修饰的方法,它的调用依赖于操作系统 - 当操作系统认为当前可以创建线程的时候,线程才会被创建

8、查看进程线程的方法

- windows

- 任务管理器可以查看进程和线程数,也可以用来杀死进程

tasklist查看进程taskkill杀死进程

- linux

ps -fe查看所有进程ps -fT -p <PID>查看某个进程(PID)的所有线程kill杀死进程top 按大写 H切换是否显示线程top -H -p <PID>查看某个进程(PID)的所有线程

- Java

jps 命令查看所有 Java 进程jstack <PID>查看某个 Java 进程(PID)的所有线程状态jconsole来查看某个 Java 进程中线程的运行情况(图形界面)- jconsole 远程监控配置:

- 需要以如下方式运行你的 java 类

- java -Djava.rmi.server.hostname=

ip地址-Dcom.sun.management.jmxremote -

Dcom.sun.management.jmxremote.port=连接端口-Dcom.sun.management.jmxremote.ssl=是否安全连接 -Dcom.sun.management.jmxremote.authenticate=是否认证 java类

- java -Djava.rmi.server.hostname=

- 修改 /etc/hosts 文件将 127.0.0.1 映射至主机名

- 如果要认证访问,还需要做如下步骤:

- 复制 jmxremote.password 文件

- 修改 jmxremote.password 和 jmxremote.access 文件的权限为 600 即文件所有者可读写

- 连接时填入 controlRole(用户名),R&D(密码)

- 需要以如下方式运行你的 java 类

- jconsole 远程监控配置:

9、线程运行的原理

1、栈与栈帧

JVM 中由堆、栈、方法区所组成。

Java Virtual Machine Stacks (Java 虚拟机栈):每个线程启动后,虚拟机就会为其分配一块栈内存

我们都知道 JVM 中由堆、栈、方法区所组成,其中栈内存是给谁用的呢?

其实就是线程,每个线程启动后,虚拟机就会为其分配一块栈内存。

- 每个栈由多个栈帧(Frame)组成,对应着每次方法调用时所占用的内存

- 每个线程只能有一个活动栈帧,对应着当前正在执行的那个方法

2、线程上下文切换(Thread Context Switch)

因为以下一些原因导致 cpu 不再执行当前的线程,转而执行另一个线程的代码。原因:

- 线程的 cpu 时间片用完

- 垃圾回收

- 有更高优先级的线程需要运行

- 线程自己调用了

sleep、yield、wait、join、park、synchronized、lock等方法

当 Context Switch 发生时,需要由操作系统保存当前线程的状态,并恢复另一个线程的状态,Java 中对应的概念就是程序计数器(Program Counter Register),它的作用是记住下一条 jvm 指令的执行地址,是线程私有的。

- 状态包括程序计数器、虚拟机栈中每个栈帧的信息,如局部变量、操作数栈、返回地址等

- Java 创建的线程是内核级线程,线程的调度是在内核态运行的,而线程中的代码是在用户态运行,所以线程切换(状态改变)会导致用户与内核态转换,这是非常消耗性能

- Java 中 main 方法启动的是一个进程也是一个主线程,main 方法里面的其他线程均为子线程

5、线程的常见方法

| 方法名 | static(静态) | 功能说明 | 注意 |

|---|---|---|---|

| start() | 启动一个新线程,在新的线程运行 run 方法中的代码 | start 方法只是让线程进入就绪,里面代码不一定立刻运行(CPU 的时间片还没分给它)。每个线程对象的start方法只能调用一次,如果调用了多次会出现 IllegalThreadStateException | |

| run() | 新线程启动后会调用的方法 | 如果在构造 Thread 对象时传递了 Runnable 参数,则线程启动后会调用 Runnable 中的 run 方法,否则默认不执行任何操作。但可以创建 Thread 的子类对象,来覆盖默认行为 | |

| join() | 等待线程运行结束 | ||

| join(long n) | 等待线程运行结束,最多等待 n 毫秒 | ||

| getId() | 获取线程长整型的 id | id 唯一 | |

| getName() | 获取线程名 | ||

| setName(String) | 修改线程名 | ||

| getPriority() | 获取线程优先级 | ||

| setPriority(int) | 修改线程优先级 | java中规定线程优先级是1~10 的整数,较大的优先级能提高该线程被 CPU 调度的机率 | |

| getState() | 获取线程状态 | Java 中线程状态是用 6 个 enum 表示,分别为:NEW, RUNNABLE, BLOCKED, WAITING, TIMED_WAITING, TERMINATED |

|

| isInterrupted() | 判断是否被打断 | 不会清除==打断标记== | |

| isAlive() | 线程是否存活(还没有运行完毕) | ||

| interrupt() | 打断线程 | 如果被打断线程正在 sleep,wait,join 会导致被打断的线程抛出 InterruptedException,并清除==打断标记== ;如果打断的正在运行的线程,则会设置==打断标记==;park 的线程被打断,也会设置==打断标记== |

|

| interrupted() | static | 判断当前线程是否被打断 | 会清除==打断标记== |

| currentThread() | static | 获取当前正在执行的线程 | |

| sleep(long n) | static | 让当前执行的线程休眠n毫秒,休眠时让出 cpu 的时间片给其它线程 | |

| yield() | static | 提示线程调度器让出当前线程对CPU的使用 | 主要是为了测试和调试 |

6、不推荐的方法

还有一些不推荐使用的方法,这些方法已过时,容易破坏同步代码块,造成线程死锁

| 方法名 | static | 功能说明 |

|---|---|---|

| stop() | 停止线程运行 | |

| suspend() | 挂起(暂停)线程运行 | |

| resume() | 恢复线程运行 |

7、基础线程机制

1、Executor

Executor 管理多个异步任务的执行,而无需程序员显式地管理线程的生命周期。这里的异步是指多个任务的执行互不干扰,不需要进行同步操作。

主要有三种 Executor:

CachedThreadPool: 一个任务创建一个线程;FixedThreadPool:所有任务只能使用固定大小的线程;SingleThreadExecutor:相当于大小为 1 的 FixedThreadPool。

具体使用:(代码)

1 | public static void main(String[] args) { |

2、Daemon

守护线程是程序运行时在后台提供服务的线程,属于程序中不可或缺的一部分。

当所有非守护线程结束时,程序也就终止,同时会杀死所有守护线程。

main() 属于非守护线程。

使用 setDaemon() 方法将一个线程设置为守护线程。

1 | public static void main(String[] args) { |

3、sleep()

Thread.sleep(millisec) 方法会休眠当前正在执行的线程,millisec 单位为==毫秒==。

sleep() 可能会抛出 InterruptedException,因为异常不能跨线程传播回 main() 中,因此必须在本地进行处理。线程中抛出的其它异常也同样需要在本地进行处理。

1 | public void run() { |

案例——防止CPU占用100%

在没有利用 cpu 来计算时,不要让 while(true) 空转浪费 cpu,这时可以使用 yield 或 sleep 来让出 cpu 的使用权给其他程序

1 | public class TestCpu { |

- 可以用 wait 或 条件变量达到类似的效果

- 不同的是,后两种都需要加锁,并且需要相应的唤醒操作,一般适用于要进行同步的场景

- sleep 适用于无需锁同步的场景

4、yield()

对静态方法 Thread.yield() 的调用声明了当前线程已经完成了生命周期中最重要的部分,可以切换给其它线程来执行(让位操作)。该方法只是对线程调度器的一个建议,而且也只是建议具有相同优先级的其它线程可以运行。

1 | public void run() { |

5、run/start、sleep/yield、线程优先级

1、run与start

1、run

run:称为线程体,包含了要执行的这个线程的内容,方法运行结束,此线程随即终止。直接调用 run 是在主线程中执行了 run,没有启动新的线程,需要顺序执行

2、start

start:使用 start 是启动新的线程,此线程处于就绪(可运行)状态,通过新的线程间接执行 run 中的代码

说明:线程控制资源类

3、面试问题:run() 方法中的异常不能抛出,只能 try/catch

- 因为父类中没有抛出任何异常,子类不能比父类抛出更多的异常

- 异常不能跨线程传播回 main() 中,因此必须在本地进行处理

4、run与start之间的区别

直接调用 run 是在主线程中执行了 run,没有启动新的线程,相当于变成了普通类的执行,此时将只有主线程在执行该线程

使用 start 是启动新的线程,通过新的线程间接执行 run 中的代码

调用start()方法之前与之后线程的状态:

代码:

public class Test5 { public static void main(String[] args) { Thread t1 = new Thread("t1") { @Override public void run() { log.debug("running..."); } }; System.out.println(t1.getState()); t1.start(); System.out.println(t1.getState()); } }1

2

3

4

5

6

7

- 结果:

- ```sh

NEW

RUNNABLE

12:51:05.298 [t1] c.Test5 - running...

2、sleep与yield之间的区别

1、sleep

- 调用 sleep 会让当前线程从

Running进入Timed Waiting状态(阻塞)- 使用sleep后,线程失去cpu的时间片。同时也不能在获取cpu的时间片。

- 其它线程可以使用 interrupt 方法打断正在睡眠的线程,这时 sleep 方法会抛出 InterruptedException

- 睡眠结束后的线程未必会立刻得到执行

- 建议用 TimeUnit 的 sleep 代替 Thread 的 sleep 来获得更好的可读性

2、yield

- 调用 yield 会让当前线程从

Running进入Runnable就绪状态,然后调度执行其它线程- 使用yield后,如果线程进入Runnable就绪状态还是有可能签到cpu时间片的,这是与sleep()最大的不同

- 具体的实现依赖于操作系统的任务调度器

- 会放弃 CPU 资源,锁资源不会释放

3、线程优先级(priority)

- 线程优先级会提示(hint)调度器优先调度该线程,但它仅仅是一个提示,调度器可以忽略它

- 如果 cpu 比较忙,那么优先级高的线程会获得更多的时间片,但 cpu 闲时,优先级几乎没作用

8、线程中断

一个线程执行完毕之后会自动结束,如果在运行过程中发生异常也会提前结束。

1、InterruptedException

通过调用一个线程的 interrupt() 来中断该线程,如果该线程处于阻塞、限期等待或者无限期等待状态,那么就会抛出 InterruptedException,从而提前结束该线程。但是不能中断 I/O 阻塞和 synchronized 锁阻塞。

对于以下代码,在 main() 中启动一个线程之后再中断它,由于线程中调用了 Thread.sleep() 方法,因此会抛出一个 InterruptedException,从而提前结束线程,不执行之后的语句。

1 | public class InterruptExample { |

1 | public static void main(String[] args) throws InterruptedException { |

1 | Main run |

2、interrupted()

如果一个线程的 run() 方法执行一个无限循环,并且没有执行 sleep() 等会抛出 InterruptedException 的操作,那么调用线程的 interrupt() 方法就无法使线程提前结束。

但是调用 interrupt() 方法会设置线程的中断标记,此时调用 interrupted() 方法会返回 true。因此可以在循环体中使用 interrupted() 方法来判断线程是否处于中断状态,从而提前结束线程。

1 | public class InterruptExample { |

1 | public static void main(String[] args) throws InterruptedException { |

1 | Thread end |

3、Executor 的中断操作

- 调用 Executor 的

shutdown()方法会等待线程都执行完毕之后再关闭, - 但是如果调用的是

shutdownNow()方法,则相当于调用每个线程的 interrupt() 方法。

以下使用 Lambda 创建线程,相当于创建了一个匿名内部线程。

1 | public static void main(String[] args) { |

1 | Main run |

如果只想中断 Executor 中的一个线程,可以通过使用 submit() 方法来提交一个线程,它会返回一个 Future<?> 对象,通过调用该对象的 cancel(true) 方法就可以中断线程。

1 | Future<?> future = executorService.submit(() -> { |

9、线程互斥同步

Java 提供了两种锁机制来控制多个线程对共享资源的互斥访问:

- 第一个是 JVM 实现的 synchronized;

- 而另一个是 JDK 实现的 ReentrantLock。

1、synchronized

1、同步一个代码块

1 | public void func() { |

它只作用于同一个对象,如果调用两个对象上的同步代码块,就不会进行同步。

对于以下代码,使用 ExecutorService 执行了两个线程,由于调用的是同一个对象的同步代码块,因此这两个线程会进行同步,当一个线程进入同步语句块时,另一个线程就必须等待。

1 | public class SynchronizedExample { |

1 | public static void main(String[] args) { |

1 | 0 1 2 3 4 5 6 7 8 9 0 1 2 3 4 5 6 7 8 9 |

2、同步一个方法

1 | public synchronized void func () { |

它和同步代码块一样,作用于同一个对象。

3、同步一个类

1 | public void func() { |

作用于整个类,也就是说两个线程调用同一个类的不同对象上的这种同步语句,也会进行同步。

1 | public class SynchronizedExample { |

1 | public static void main(String[] args) { |

1 | 0 1 2 3 4 5 6 7 8 9 0 1 2 3 4 5 6 7 8 9 |

4、同步一个静态方法

1 | public synchronized static void fun() { |

作用于整个类。

2、ReentrantLock(JUC中的ReentrantLock)

ReentrantLock 是 java.util.concurrent(J.U.C)包中的锁。

1 | public class LockExample { |

1 | public static void main(String[] args) { |

1 | 0 1 2 3 4 5 6 7 8 9 0 1 2 3 4 5 6 7 8 9 |

3、比较

- 锁的实现

- synchronized 是 JVM 实现的,而 ReentrantLock 是 JDK 实现的。

- 性能

- 新版本 Java 对 synchronized 进行了很多优化,例如==自旋锁==等,synchronized 与 ReentrantLock 大致相同。

- 等待可中断

- 当持有锁的线程长期不释放锁的时候,正在等待的线程可以选择放弃等待,改为处理其他事情。

- ReentrantLock 可中断;

- 而 synchronized 不行。

- 当持有锁的线程长期不释放锁的时候,正在等待的线程可以选择放弃等待,改为处理其他事情。

- 公平锁

- 公平锁是指多个线程在等待同一个锁时,必须按照申请锁的时间顺序来依次获得锁。

- synchronized 中的锁是非公平的;

- ReentrantLock 默认情况下也是非公平的,但是也可以是公平的。

- 公平锁是指多个线程在等待同一个锁时,必须按照申请锁的时间顺序来依次获得锁。

- 锁绑定多个条件

- 一个 ReentrantLock 可以同时绑定多个 Condition 对象。

4、使用选择

除非需要使用 ReentrantLock 的高级功能,否则优先使用 synchronized。

这是因为:

- synchronized 是 JVM 实现的一种锁机制,JVM 原生地支持它,而 ReentrantLock 不是所有的 JDK 版本都支持。

- 并且使用 synchronized 不用担心没有释放锁而导致死锁问题,因为 JVM 会确保锁的释放。

10、线程之间的协作

当多个线程可以一起工作去解决某个问题时,如果某些部分必须在其它部分之前完成,那么就需要对线程进行协调。

1、join()

在线程中调用另一个线程的 join() 方法,会将当前线程挂起,而不是忙等待,直到目标线程结束。

原理:调用者轮询检查线程 alive 状态,t1.join()等价于:原理:调用者轮询检查线程 alive 状态,t1.join()等价于:

1 | synchronized (t1) { |

- join 方法是被 synchronized 修饰的,本质上是一个对象锁,其内部的 wait 方法调用也是释放锁的,但是释放的是当前线程的对象锁,而不是外面的锁

- t1 会强占 CPU 资源,直至线程执行结束,当调用某个线程的 join 方法后,该线程抢占到 CPU 资源,就不再释放,直到线程执行完毕

线程同步:

- join 实现线程同步,因为会阻塞等待另一个线程的结束,才能继续向下运行

- 需要外部共享变量,不符合面向对象封装的思想

- 必须等待线程结束,不能配合线程池使用

- Future 实现(同步):get() 方法阻塞等待执行结果

- main 线程接收结果

- get 方法是让调用线程同步等待

1 | public class Test { |

1、为什么需要join()

如果想要某线程(A)优先于某线程(B)运行(场景:线程B需要线程A的运算结果),这个时候就得线程B就需要使用join()来挂起当前线程,直到目标线程(A)结束。

对于以下代码,虽然 b 线程先启动,但是因为在 b 线程中调用了 a 线程的 join() 方法,b 线程会等待 a 线程结束才继续执行,因此最后能够保证 a 线程的输出先于 b 线程的输出。

1 | public class JoinExample { |

1 | public static void main(String[] args) { |

1 | A |

2、为什么不用sleep(),而使用join()

使用sleep也可以实现以上效果,但是不好:因为在设计情况下你不清楚A线程需要多次时间得到运算结果,所以B线程不知道要sleep多少时间。

3、join(long)

join(long)可以设置等待时间,单位是ms。

- 如果到了设置的时间还没有结果,线程会结束等待,继续往下运行

- 如果在设置的时间之前就应经有结果了,线程会立即往下运行,不会等到设定的时间

4、join的底层原理——保护性暂停模式的时间增强

先看一下join的源码:

1 | public final void join() throws InterruptedException { |

可以将join的底层实现与保护性暂停模式的时间增强进行对比,会发现join的底层用的是保护性暂停模式的时间增强

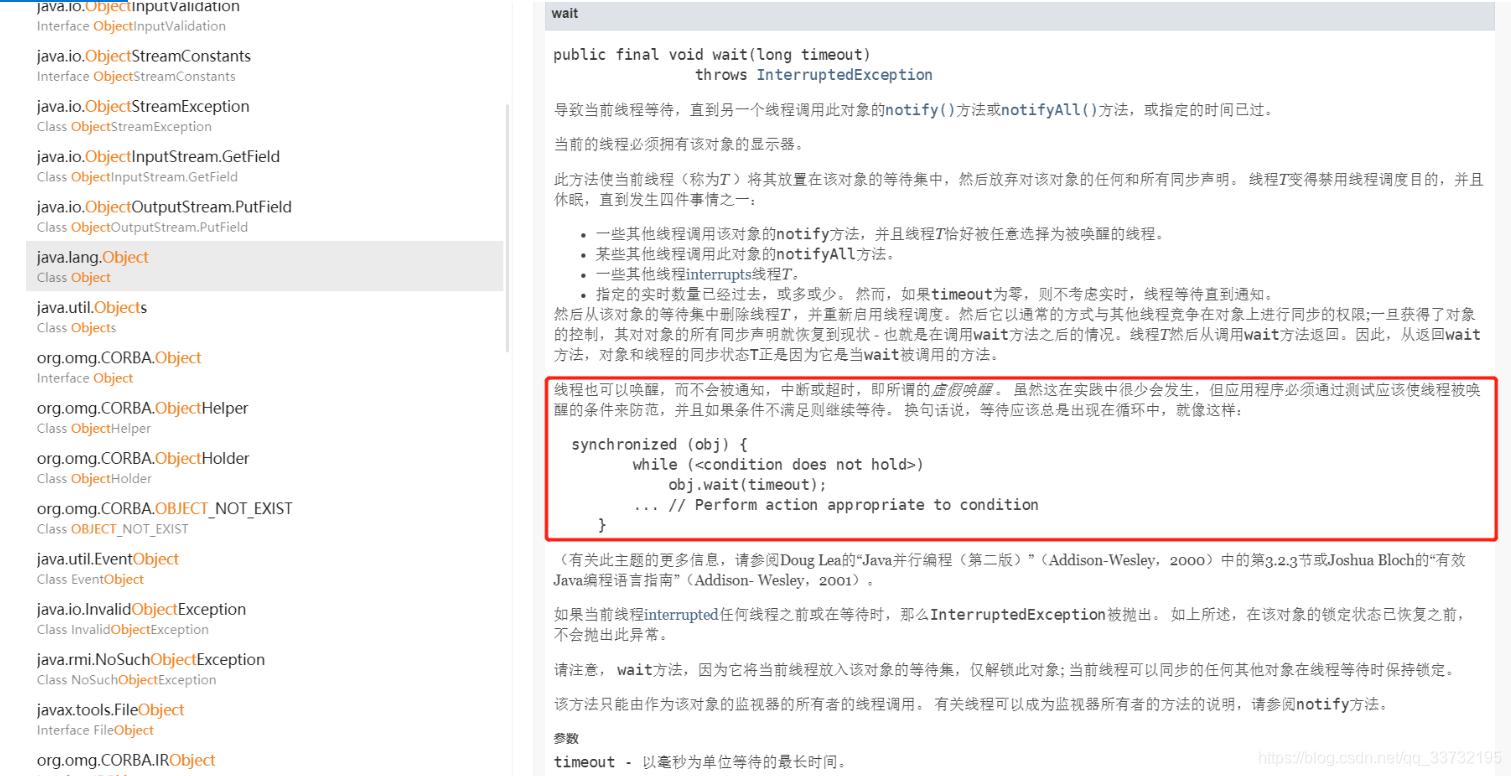

2、wait()、notify()、notifyAll()

调用 wait() 使得线程等待某个条件满足,线程在等待时会被挂起,当其他线程的运行使得这个条件满足时,其它线程会调用 notify() 或者 notifyAll() 来唤醒挂起的线程。

obj.wait()让进入 object 监视器的线程到 waitSet 等待wait() 方法会释放对象的锁,进入 WaitSet 等待区,从而让其他线程就机会获取对象的锁。无限制等待,直到notify 为止

wait(long n) 有时限的等待, 到 n 毫秒后结束等待,或是被 notify

其实还有一个wait(long timeout, int nanos)方法,只是这个方法是一个无效方法:它的意思是可以把时间精确到纳秒,而实际上无论你在第二个参数填写什么值(大于0小于999999),他都只是将第一个参数的值加一

public final void wait(long timeout, int nanos) throws InterruptedException { if (timeout < 0) { throw new IllegalArgumentException("timeout value is negative"); } if (nanos < 0 || nanos > 999999) { throw new IllegalArgumentException( "nanosecond timeout value out of range"); } if (nanos > 0) { timeout++; } wait(timeout); }1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

- `obj.notify()` 在 object 上正在 waitSet 等待的线程中挑一个唤醒

- `obj.notifyAll()` 让 object 上正在 waitSet 等待的线程全部唤醒

**它们都属于 Object 的一部分,而不属于 Thread**。

**==只能用在同步方法或者同步控制块中使用==**,否则会在运行时抛出 `IllegalMonitorStateExeception`。也侧面说明了wait/notify只能用在重量级锁。

**使用 wait() 挂起期间,线程会释放锁**。这是因为,如果没有释放锁,那么其它线程就无法进入对象的同步方法或者同步控制块中,那么就无法执行 notify() 或者 notifyAll() 来唤醒挂起的线程,造成死锁。

```java

public class WaitNotifyExample {

public synchronized void before() {

System.out.println("before");

notifyAll();

}

public synchronized void after() {

try {

wait();

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("after");

}

}

1 | public static void main(String[] args) { |

1 | before |

1、wait() 和 sleep() 的区别

- sleep 是 Thread 的静态方法,wait 是 Object 的方法,任何对象实例都能调用;

- **sleep 不会释放锁,它也不需要占用锁。wait 会释放锁,但调用它的前提是当前线程占有锁(即代码要在 synchronized 中)**。

- sleep 不需要强制和 synchronized 配合使用,但 wait 需要和 synchronized 一起用

2、wait() 和 sleep() 的共同点

- 它们都可以被 interrupted 方法中断。

- 它们状态

TIMED_WAITING - 在哪里睡着,就在哪里醒来。

3、await()、signal()、signalAll()

java.util.concurrent 类库中提供了 Condition 类来实现线程之间的协调,可以在 Condition 上调用 await() 方法使线程等待,其它线程调用 signal() 或 signalAll() 方法唤醒等待的线程。相比于 wait() 这种等待方式,await() 可以指定等待的条件,因此更加灵活。

使用 Lock 来获取一个 Condition 对象。

1 | public class AwaitSignalExample { |

1 | public static void main(String[] args) { |

1 | before |

4、interrupt

1、打断 sleep,wait,join 的线程

sleep,wait,join、这几个方法都会让线程进入阻塞状态(join底层就是wait,其实join与wait本质上是一样的)

可以使用interrupt方法来打断线程:

- 如果打断的是阻塞的线程,会清空打断状态,打断状态为false

- 如果打断的是正常运行的线程,不会清空打断状态,打断状态为true

- 对于Running的线程,也就是正常运行的线程被打断(interrupt)后,不会立刻中断它,而是将其的打断标记isInterrupted()设置为true,可以在正常运行的线程中通过这个打断标记来选择是否终止自身线程。

- 也就是说:因为直接把线程终结了,人家线程事情都没干完。不如跟他说一声,说我要打断你,他处理完事情后自行了断不更好

2、多线程设计模式——两阶段终止

详细请看——并发的相关多线程设计模式

3、打断 park 线程

打断 park 线程,不会清空打断状态

1 | public static void main(String[] args) { |

输出:

1 | 21:11:19.373 [t1] c.TestInterrupt - park... |

如果打断标记已经是 true,则 park 会失效

1 | public static void main(String[] args) { |

输出:

1 | 21:11:54.003 [t1] c.TestInterrupt - park... |

提示:可以使用 Thread.interrupted() 清除打断状态

1 | log.debug("打断状态:{}", Thread.currentThread().interrupted()); |

4、关键字:synchronized详解

在C程序代码中我们可以利用操作系统提供的互斥锁来实现同步块的互斥访问及线程的阻塞及唤醒等工作。在Java中除了提供Lock API外还在语法层面上提供了synchronized关键字来实现互斥同步原语。

1、BAT大厂的面试问题

- Synchronized可以作用在哪里?分别通过对象锁和类锁进行举例。

- Synchronized本质上是通过什么保证线程安全的?

- 分三个方面回答:

- 加锁和释放锁的原理

- 可重入原理

- 保证可见性原理

- 分三个方面回答:

- Synchronized有什么样的缺陷?Java Lock是怎么弥补这些缺陷的?

- Synchronized和Lock的对比,和选择?

- Synchronized在使用时有何注意事项?

- Synchronized修饰的方法在抛出异常时,会释放锁吗?

- 多个线程等待同一个snchronized锁的时候,JVM如何选择下一个获取锁的线程?

- Synchronized使得同时只有一个线程可以执行,性能比较差,有什么提升的方法?

- 我想更加灵活地控制锁的释放和获取(现在释放锁和获取锁的时机都被规定死了),怎么办?

- 什么是锁的升级和降级?什么是JVM里的偏斜锁、轻量级锁、重量级锁?

- 不同的JDK中对Synchronized有何优化?

2、Synchronized的使用

在应用Sychronized关键字时需要把握如下注意点:

- 一把锁只能同时被一个线程获取,没有获得锁的线程只能等待;

- 每个实例都对应有自己的一把锁(this),不同实例之间互不影响;

- 例外:*锁对象是.class以及synchronized修饰的是static方法的时候,所有对象公用同一把锁**。

- synchronized修饰的方法,无论方法正常执行完毕还是抛出异常,都会==释放锁==

1、对象锁

包括==方法锁==(默认锁对象为this,当前实例对象)和==同步代码块锁==(自己指定锁对象)

1、代码块形式

手动指定锁定对象:

可以是this:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24public class SynchronizedObjectLock implements Runnable {

static SynchronizedObjectLock instence = new SynchronizedObjectLock();

public void run() {

// 同步代码块形式——锁为this,两个线程使用的锁是一样的,线程1必须要等到线程0释放了该锁后,才能执行

synchronized (this) {

System.out.println("我是线程" + Thread.currentThread().getName());

try {

Thread.sleep(3000);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println(Thread.currentThread().getName() + "结束");

}

}

public static void main(String[] args) {

Thread t1 = new Thread(instence);

Thread t2 = new Thread(instence);

t1.start();

t2.start();

}

}1

2

3

4我是线程Thread-0

Thread-0结束

我是线程Thread-1

Thread-1结束也可以是自定义的锁

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37public class SynchronizedObjectLock implements Runnable {

static SynchronizedObjectLock instence = new SynchronizedObjectLock();

// 创建2把锁

Object block1 = new Object();

Object block2 = new Object();

public void run() {

// 这个代码块使用的是第一把锁,当他释放后,后面的代码块由于使用的是第二把锁,因此可以马上执行

synchronized (block1) {

System.out.println("block1锁,我是线程" + Thread.currentThread().getName());

try {

Thread.sleep(3000);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("block1锁,"+Thread.currentThread().getName() + "结束");

}

synchronized (block2) {

System.out.println("block2锁,我是线程" + Thread.currentThread().getName());

try {

Thread.sleep(3000);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("block2锁,"+Thread.currentThread().getName() + "结束");

}

}

public static void main(String[] args) {

Thread t1 = new Thread(instence);

Thread t2 = new Thread(instence);

t1.start();

t2.start();

}

}1

2

3

4

5

6

7

8block1锁,我是线程Thread-0

block1锁,Thread-0结束

block2锁,我是线程Thread-0 // 可以看到当第一个线程在执行完第一段同步代码块之后,第二个同步代码块可以马上得到执行,因为他们使用的锁不是同一把

block1锁,我是线程Thread-1

block2锁,Thread-0结束

block1锁,Thread-1结束

block2锁,我是线程Thread-1

block2锁,Thread-1结束

2、方法锁形式:synchronized修饰普通方法,锁对象默认为this

1 | public class SynchronizedObjectLock implements Runnable { |

1 | 我是线程Thread-0 |

2、类锁

指synchronize修饰静态的方法或指定锁对象为Class对象。

1、synchronize修饰静态方法

synchronize修饰普通方法与修饰静态方法的区别:

- synchronized用在普通方法上,默认的锁就是this,当前实例

- synchronized用在静态方法上,默认的锁就是当前所在的Class类,所以无论是哪个线程访问它,需要的锁都只有一把

修饰普通方法:

1 | public class SynchronizedObjectLock implements Runnable { |

1 | 我是线程Thread-0 |

修饰静态方法

1 | public class SynchronizedObjectLock implements Runnable { |

1 | 我是线程Thread-0 |

2、synchronized指定锁对象为Class对象

1 | public class SynchronizedObjectLock implements Runnable { |

1 | 我是线程Thread-0 |

3、关于synchronized锁的总结

对于Synchronized实现同步的基础:java中每一个对象都可以作为锁。

具体可以分为以下三种情况:

- 对于普通同步方法,锁是当前实例对象;(对象锁)

- 对于静态同步方法,锁是当前类的Class 对象;(类锁)

- 对于同步方法块,锁是Synchonized 括号里配置的对象

对于对象锁:

- 如果一个实例对象的非静态同步方法获取锁后,该实例对象的其他非静态同步方法必须等待获取锁的方法释放锁后才能获取锁;

- 别的实例对象的非静态同步方法因为跟该实例对象的非静态同步方法用的是不同的锁, 所以无须等待该实例对象已获取锁的非静态同步方法释放锁就可以获取他们自己的锁;

- 每一个对象都有属于自己的对象锁(可以有多把对象锁)。

对于类锁:

- 所有的静态同步方法用的也是同一把锁——类对象本身(类锁),这与对象锁是两个不同的对象,所以静态同步方法与非静态同步方法之间是不会有竞态条件的;

- 一旦一个静态同步方法获取锁后,其他的静态同步方法都必须等待该方法释放锁后才能获取锁;

- 但不管是同一个实例对象的静态同步方法之间,还是不同的实例对象的静态同步方法之间,只要它们同一个类的实例对象!

- 类锁只有一把。

对于同步代码块:

- 同步代码块的锁是Synchonized 括号里配置的对象;

- 如果Synchonized 括号里是对象,那么他就是对象锁;如果Synchonized 括号里是类,那么他就是类锁;

- 所以他可以有一把,也可以有多把(主要看如果Synchonized 括号里是类还是对象)

举个例子:把synchronized的锁看成一座大楼

- 类锁就是锁住大楼的锁

- 对象锁就是锁住大楼里面房间的锁,每一个房间都有属于它的一把锁

3、Synchronized的原理分析

1、加锁和释放锁的原理

现象、时机(内置锁this)、深入JVM看字节码(反编译看monitor指令)

深入JVM看字节码,创建如下的代码:

1

2

3

4

5

6

7

8public class SynchronizedDemo2{

static final Object lock = new Object(); static int counter = 0;

public static void main(String[] args) {

synchronized (lock) {

counter++;

}

}

}使用javac命令进行编译生成.class文件

1

>javac SynchronizedDemo2.java

使用javap命令反编译查看.class文件的信息

1

>javap -verbose SynchronizedDemo2.class

得到如下的信息:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38Code:

stack=2,locals=3,args_size=1

0: getstatic #2 // <- lock引用( synchronized开始)

3: dup

4: astore_1 // lock引用 -> slot 1

5: monitorenter // 将lock对象 MarkWord 置为 Monitor 指针

6: getstatic #3 // <- i

9: iconst_1 // 准备常数1

10: iadd // +1

11: putstatic #3 // -> i

14: aload_1 // <- lock引用

15: monitorexit // 将lock对象 MarkWord 重置,唤醒EntryList

16: goto 24

19: astore_2 // e -> slot2

20: aload_1 // <- lock引用

21: monitorexit // 将 lock 对象 MarkWord 重置,唤醒EntryList

22: aload_2 // <- slot 2 (e)

23: athrow // throw e

24: return

Exception table:

from to target type

6 16 19 any

19 22 19 any

LineNumberTable:

line 8: 0

line 9: 6

line 10: 14

line 11: 24

LocalVar iableTable:

Start Length Slot Name Signature

0 25 0 args [Ljava/lang/String;

StackMapTable: number_of_entries = 2

frame_type = 255 /* full_ _frame */

offset_delta = 19

locals = [ class "[Ljava/lang/String;", class java/lang/object ]

stack = [ class java/lang/Throwable ]

frame_type = 250 /* chop */

offset_delta = 4

注意:

- 方法级别的 synchronized 不会在字节码指令中有所体现

- 在字节码中的

16: goto 24当中,执行到这里会跳转到第24行的字节码执行24:return返回 - 那么第19行到第23行的字节码的作用是什么?

- 仔细阅读字节码的内容会发现:他们的作用是当同步代码块中的内容出现异常的时候,为了防止当前的锁得不到释放而造成死锁,在第19到第23行进行异常的抛出和锁的释放

关注字节码当中的monitorenter和monitorexit即可。

Monitorenter和Monitorexit指令,会让对象在执行,使其锁计数器加1或者减1。每一个对象在同一时间只与一个monitor(锁)相关联,而一个monitor在同一时间只能被一个线程获得,一个对象在尝试获得与这个对象相关联的Monitor锁的所有权的时候,monitorenter指令会发生如下3中情况之一:

- monitor计数器为0,意味着目前还没有被获得,那这个线程就会立刻获得然后把锁计数器+1,一旦+1,别的线程再想获取,就需要等待

- 如果这个monitor已经拿到了这个锁的所有权,又重入了这把锁,那锁计数器就会累加,变成2,并且随着重入的次数,会一直累加

- 这把锁已经被别的线程获取了,等待锁释放

monitorexit指令:释放对于monitor的所有权,释放过程很简单,就是讲monitor的计数器减1,如果减完以后,计数器不是0,则代表刚才是重入进来的,当前线程还继续持有这把锁的所有权,如果计数器变成0,则代表当前线程不再拥有该monitor的所有权,即释放锁。

下图表现了对象,对象监视器,同步队列以及执行线程状态之间的关系:

该图可以看出,任意线程对Object的访问,首先要获得Object的监视器monitor,如果获取失败,该线程就进入同步状态,线程状态变为BLOCKED,当Object的监视器占有者释放后,在同步队列中得线程就会有机会重新获取该监视器。

2、可重入原理:加锁次数计数器

上面的demo中在执行完同步代码块之后紧接着再会去执行一个静态同步方法,而这个方法锁的对象依然就这个类对象,那么这个正在执行的线程还需要获取该锁吗? 答案是不必的,从上图中就可以看出来,执行静态同步方法的时候就只有一条monitorexit指令,并没有monitorenter获取锁的指令。这就是锁的重入性,即在同一锁程中,线程不需要再次获取同一把锁。

Synchronized先天具有重入性。每个对象拥有一个计数器,当线程获取该对象锁后,计数器就会加一,释放锁后就会将计数器减一。

3、保证可见性的原理:内存模型和happens-before规则

Synchronized的happens-before规则,即监视器锁规则:对同一个监视器的解锁,happens-before于对该监视器的加锁。继续来看代码:

1 | public class MonitorDemo { |

该代码的happens-before关系如图所示:

在图中每一个箭头连接的两个节点就代表之间的happens-before关系:

- 黑色的是通过程序顺序规则推导出来,

- 红色的为监视器锁规则推导而出:

- 线程A释放锁happens-before线程B加锁;

- 蓝色的则是通过程序顺序规则和监视器锁规则推测出来happens-befor关系,通过传递性规则进一步推导的happens-before关系。

- 现在我们来重点关注:

2 happens-before 5,通过这个关系我们可以得出什么?- 根据happens-before的定义中的一条:如果A happens-before B,则A的执行结果对B可见,并且A的执行顺序先于B。线程A先对共享变量A进行加一,由

2 happens-before 5关系可知线程A的执行结果对线程B可见即线程B所读取到的a的值为1。

- 根据happens-before的定义中的一条:如果A happens-before B,则A的执行结果对B可见,并且A的执行顺序先于B。线程A先对共享变量A进行加一,由

- 现在我们来重点关注:

4、synchronized 是给对象加锁的原理——对象的对象头

synchronized 对对象进行加锁,在 JVM 中,对象在内存中分为三块区域:对象头(Header)、实例数据(Instance Data)和对齐填充(Padding)。

- 对象头:我们以Hotspot虚拟机为例,Hotspot的对象头主要包括两部分数据:

- Mark Word(标记字段)

- Klass Pointer(类型指针)

以 32 位虚拟机为例:

普通对象:

1 | |--------------------------------------------------------------| |

数组对象:

1 | |---------------------------------------------------------------------------------| |

其中 Mark Word 结构为:

1 | |-------------------------------------------------------|--------------------| |

64 位虚拟机 Mark Word:

1 | |--------------------------------------------------------------------|--------------------| | Mark Word (64 bits) | State | |--------------------------------------------------------------------|--------------------| | unused:25 | hashcode:31 | unused:1 | age:4 | biased_lock:0 | 01 | Normal | |--------------------------------------------------------------------|--------------------| | thread:54 | epoch:2 | unused:1 | age:4 | biased_lock:1 | 01 | Biased | |--------------------------------------------------------------------|--------------------| | ptr_to_lock_record:62 | 00 | Lightweight Locked | |--------------------------------------------------------------------|--------------------| | ptr_to_heavyweight_monitor:62 | 10 | Heavyweight Locked | |--------------------------------------------------------------------|--------------------| |

Monitor 被翻译为监视器或管程

每个 Java 对象都可以关联一个 Monitor 对象,如果使用 synchronized 给对象上锁(重量级)之后,该对象头的Mark Word 中就被设置指向 Monitor 对象的指针,如下图所示,右侧就是对象对应的 Monitor 对象。

当 Monitor 被某个线程持有后,就会处于锁定状态,如图中的 Owner 部分,会指向持有 Monitor 对象的线程。

另外 Monitor 中还有两个队列分别是EntryList和WaitList,主要是用来存放进入及等待获取锁的线程。

如果线程进入,则得到当前对象锁,那么别的线程在该类所有对象上的任何操作都不能进行。

- Mark Word:默认存储对象的HashCode,分代年龄和锁标志位信息。它会根据对象的状态复用自己的存储空间,也就是说在运行期间Mark Word里存储的数据会随着锁标志位的变化而变化。

- Klass Point:对象指向它的类元数据的指针,虚拟机通过这个指针来确定这个对象是哪个类的实例。

Monitor 结构如下

- 刚开始 Monitor 中 Owner 为 null

- 当 Thread-2 执行 synchronized(obj) 就会将 Monitor 的所有者 Owner 置为 Thread-2,Monitor中只能有一个 Owner

- 在 Thread-2 上锁的过程中,如果 Thread-3,Thread-4,Thread-5 也来执行 synchronized(obj),就会进入 EntryList BLOCKED

- Thread-2 执行完同步代码块的内容,然后唤醒 EntryList 中等待的线程来竞争锁,竞争的时是非公平的

- 图中 WaitSet 中的 Thread-0,Thread-1 是之前获得过锁,但条件不满足进入 WAITING 状态的线程

- Owner 线程发现条件不满足,调用 wait 方法,即可进入 WaitSet 变为 WAITING 状态

- BLOCKED 和 WAITING 的线程都处于阻塞状态,不占用 CPU 时间片

- BLOCKED 线程会在 Owner 线程释放锁时唤醒

- WAITING 线程会在 Owner 线程调用 notify 或 notifyAll 时唤醒,但唤醒后并不意味者立刻获得锁,仍需进入 EntryList 重新竞争

注意:

- synchronized 必须是进入同一个对象的 monitor 才有上述的效果

- 不加 synchronized 的对象不会关联监视器,不遵从以上规则

在对象级使用锁通常是一种比较粗糙的方法,为什么要将整个对象都上锁,而不允许其他线程短暂地使用对象中其他同步方法来访问共享资源?

如果一个对象拥有多个资源,就不需要只为了让一个线程使用其中一部分资源,就将所有线程都锁在外面。

由于每个对象都有锁,可以如下所示使用虚拟对象来上锁:

1 | class FineGrainLock{ |

4、JVM中锁的优化

简单来说在JVM中monitorenter和monitorexit字节码依赖于底层的操作系统的Mutex Lock来实现的,但是由于使用Mutex Lock需要将当前线程挂起并从用户态切换到内核态来执行,这种切换的代价是非常昂贵的;然而在现实中的大部分情况下,同步方法是运行在单线程环境(无锁竞争环境)下,如果每次都调用Mutex Lock那么将严重的影响程序的性能。不过在jdk1.6中对锁的实现引入了大量的优化,如锁粗化(Lock Coarsening)、锁消除(Lock Elimination)、轻量级锁(Lightweight Locking)、偏向锁(Biased Locking)、适应性自旋(Adaptive Spinning)等技术来减少锁操作的开销。

锁粗化(Lock Coarsening):也就是减少不必要的紧连在一起的unlock,lock操作,将多个连续的锁扩展成一个范围更大的锁。锁消除(Lock Elimination):通过运行时JIT编译器的逃逸分析来消除一些没有在当前同步块以外被其他线程共享的数据的锁保护,通过逃逸分析也可以在线程本地Stack上进行对象空间的分配(栈上分配)(同时还可以减少Heap上的垃圾收集开销)。轻量级锁(Lightweight Locking):这种锁实现的背后基于这样一种假设,即在真实的情况下我们程序中的大部分同步代码一般都处于无锁竞争状态(即单线程执行环境),在无锁竞争的情况下完全可以避免调用操作系统层面的重量级互斥锁,取而代之的是在monitorenter和monitorexit中只需要依靠一条CAS原子指令就可以完成锁的获取及释放。当存在锁竞争的情况下,执行CAS指令失败的线程将调用操作系统互斥锁进入到阻塞状态,当锁被释放的时候被唤醒(具体处理步骤下面详细讨论)。偏向锁(Biased Locking):是为了在无锁竞争的情况下避免在锁获取过程中执行不必要的CAS原子指令,因为CAS原子指令虽然相对于重量级锁来说开销比较小但还是存在非常可观的本地延迟。适应性自旋(Adaptive Spinning):当线程在获取轻量级锁的过程中执行CAS操作失败时,在进入与monitor相关联的操作系统重量级锁(mutex semaphore)前会进入忙等待(Spinning)然后再次尝试,当尝试一定的次数后如果仍然没有成功则调用与该monitor关联的semaphore(即互斥锁)进入到阻塞状态。

1、锁的类型

在Java SE 1.6里Synchronied同步锁,一共有四种状态:无锁、偏向锁、轻量级所、重量级锁,它会随着竞争情况逐渐升级。锁可以升级但是不可以降级,目的是为了提供获取锁和释放锁的效率。

锁膨胀方向: 无锁 → 偏向锁 → 轻量级锁 → 重量级锁 (此过程是不可逆的)

2、自旋锁与自适应自旋锁

1、自旋锁

引入背景:

大家都知道,在没有加入锁优化时,Synchronized是一个非常“胖大”的家伙。在多线程竞争锁时,当一个线程获取锁时,它会阻塞所有正在竞争的线程,这样对性能带来了极大的影响。在挂起线程和恢复线程的操作都需要转入内核态中完成,这些操作对系统的并发性能带来了很大的压力。同时HotSpot团队注意到在很多情况下,共享数据的锁定状态只会持续很短的一段时间,为了这段时间去挂起和回复阻塞线程并不值得。在如今多处理器环境下,完全可以让另一个没有获取到锁的线程在门外等待一会(自旋),但==不放弃CPU的执行时间==。等待持有锁的线程是否很快就会释放锁。为了让线程等待,我们只需要让线程执行一个忙循环(自旋),这便是自旋锁由来的原因。

自旋锁早在JDK1.4 中就引入了,只是当时默认时关闭的。在JDK 1.6后默认为开启状态。自旋锁本质上与阻塞并不相同,先不考虑其对多处理器的要求,如果锁占用的时间非常的短,那么自旋锁的新能会非常的好,相反,其会带来更多的性能开销(因为在线程自旋时,始终会占用CPU的时间片,如果锁占用的时间太长,那么自旋的线程会白白消耗掉CPU资源)。因此自旋等待的时间必须要有一定的限度,如果自选超过了限定的次数仍然没有成功获取到锁,就应该使用传统的方式去挂起线程了,在JDK定义中,自旋锁默认的自旋次数为10次,用户可以使用参数-XX:PreBlockSpin来更改。

自旋重试成功的情况:

| 线程1 (core1上) | 对象Mark | 线程2 ( core2上) |

|---|---|---|

| - | 10(重量锁) | - |

| 访问同步块,获取monitor | 10 (重量锁)重量锁指针 | - |

| 成功(加锁) | 10 (重量锁)重量锁指针 | - |

| 执行同步块 | 10 (重量锁)重量锁指针 | - |

| 执行同步块 | 10 (重量锁)重量锁指针 | 访问同步块,获取monitor |

| 执行同步块 | 10 (重量锁)重量锁指针 | 自旋重试 |

| 执行完毕 | 10 (重量锁)重量锁指针 | 自旋重试 |

| 成功(解锁) | 01(无锁) | 自旋重试 |

| - | 10 (重量锁)重量锁指针 | 成功(加锁) |

| - | 10 (重量锁)重量锁指针 | 执行同步块 |

| - | …… | …… |

自旋重试失败的情况:

| 线程1 (core1上) | 对象Mark | 线程2 ( core2上) |

|---|---|---|

| - | 10(重量锁) | - |

| 访问同步块,获取monitor | 10 (重量锁)重量锁指针 | - |

| 成功(加锁) | 10 (重量锁)重量锁指针 | - |

| 执行同步块 | 10 (重量锁)重量锁指针 | - |

| 执行同步块 | 10 (重量锁)重量锁指针 | 访问同步块,获取monitor |

| 执行同步块 | 10 (重量锁)重量锁指针 | 自旋重试 |

| 执行同步块 | 10 (重量锁)重量锁指针 | 自旋重试 |

| 执行同步块 | 10 (重量锁)重量锁指针 | 自旋重试 |

| 执行同步块 | 10 (重量锁)重量锁指针 | 阻塞 |

| - | …… | …… |

可是现在又出现了一个问题:如果线程锁在线程自旋刚结束就释放掉了锁,那么是不是有点得不偿失。所以这时候我们需要更加聪明的锁来实现更加灵活的自旋。来提高并发的性能。(这里则需要自适应自旋锁!)

2、自适应自旋锁

在JDK 1.6中引入了自适应自旋锁。这就意味着自旋的时间不再固定了,而是由前一次在同一个锁上的自旋时间及锁的拥有者的状态来决定的。如果在同一个锁对象上,自旋等待刚刚成功获取过锁,并且持有锁的线程正在运行中,那么JVM会认为该锁自旋获取到锁的可能性很大,会自动增加等待时间。比如增加到100次循环。相反,如果对于某个锁,自旋很少成功获取锁。那再以后要获取这个锁时将可能省略掉自旋过程,以避免浪费处理器资源。有了自适应自旋,JVM对程序的锁的状态预测会越来越准备,JVM也会越来越聪明。

总结:

- 自旋会占用 CPU 时间,单核 CPU 自旋就是浪费,多核 CPU 自旋才能发挥优势。

- 在 Java 6 之后自旋锁是自适应的,比如对象刚刚的一次自旋操作成功过,那么认为这次自旋成功的可能性会高,就多自旋几次;反之,就少自旋甚至不自旋,总之,比较智能。

- Java 7 之后不能控制是否开启自旋功能

3、锁消除

锁消除时指虚拟机即时编译器再运行时,对一些代码上要求同步,但是被检测到不可能存在共享数据竞争的锁进行消除。锁消除的主要判定依据来源于逃逸分析的数据支持。意思就是:JVM会判断在一段程序中的同步明显不会逃逸出去从而被其他线程访问到,那JVM就把它们当作栈上数据对待,认为这些数据时线程独有的,不需要加同步。此时就会进行锁消除。

当然在实际开发中,我们很清楚的知道那些地方时线程独有的,不需要加同步锁,但是在Java API中有很多方法都是加了同步的,那么此时JVM会判断这段代码是否需要加锁。如果数据并不会逃逸,则会进行锁消除。

比如如下操作:在操作String类型数据时,由于String是一个不可变类,对字符串的连接操作总是通过生成的新的String对象来进行的。因此Javac编译器会对String连接做自动优化。在JDK 1.5之前会使用StringBuffer对象(线程安全)的连续append()操作,在JDK 1.5及以后的版本中,会转化为StringBuidler对象(线程不安全)的连续append()操作。

1 | public static String test03(String s1, String s2, String s3) { |

对上述代码使用javap 编译的结果:

众所周知,StringBuilder不是安全同步的,但是在上述代码中,JVM判断该段代码并不会逃逸,则将该代码带默认为线程独有的资源,并不需要同步,所以执行了锁消除操作。(还有Vector中的各种操作也可实现锁消除。在没有逃逸出数据安全防卫内)

4、锁粗化

原则上,我们都知道在加同步锁时,尽可能的将同步块的作用范围限制到尽量小的范围(只在共享数据的实际作用域中才进行同步,这样是为了使得需要同步的操作数量尽可能变小。在存在锁同步竞争中,也可以使得等待锁的线程尽早的拿到锁)。

大部分上述情况是完美正确的,但是如果存在连串的一系列操作都对同一个对象反复加锁和解锁,甚至加锁操作时出现在循环体中的,那即使没有线程竞争,频繁地进行互斥同步操作也会导致不必要地性能操作。

这里贴上根据上述Javap 编译地情况编写的实例java类

1 | public static String test04(String s1, String s2, String s3) { |

在上述地连续append()操作中就属于这类情况。JVM会检测到这样一连串地操作都是对同一个对象加锁,那么JVM会将加锁同步地范围扩展(粗化)到整个一系列操作的外部,使整个一连串地append()操作只需要加锁一次就可以了。

5、轻量级锁

在JDK 1.6之后引入的轻量级锁,需要注意的是轻量级锁并不是替代重量级锁的,而是对在大多数情况下同步块并不会有竞争出现提出的一种优化。它可以减少重量级锁对线程的阻塞带来地线程开销。从而提高并发性能。

如果要理解轻量级锁,那么必须先要了解HotSpot虚拟机中对象头的内存布局。在对象头中(Object Header)存在两部分:(对象头的大小:(压缩指针)12字节,(不支持压缩指针)16字节)

- 第一部分用于存储对象自身的运行时数据,

HashCode、GC Age、锁标记位、是否为偏向锁。等。一般为32位或者64位(视操作系统位数定)。官方称之为Mark Word,它是实现轻量级锁和偏向锁的关键。 - 另外一部分存储的是指向方法区对象类型数据的指针(

Klass Point),如果对象是数组的话,还会有一个额外的部分用于存储数据的长度。

轻量级锁加锁

在线程执行同步块之前,JVM会先在当前线程的栈帧中创建一个名为锁记录(Lock Record)的空间,用于存储锁对象目前的Mark Word的拷贝(JVM会将对象头中的Mark Word拷贝到锁记录中,官方称为Displaced Mark Ward)这个时候线程堆栈与对象头的状态如图:

如上图所示:如果当前对象没有被锁定,那么锁标志位为01状态,JVM在执行当前线程时,首先会在当前线程栈帧中创建锁记录Lock Record的空间用于存储锁对象目前的Mark Word的拷贝。

然后,虚拟机使用CAS操作将标记字段Mark Word拷贝到锁记录中,并且将Mark Word更新为指向Lock Record的指针。如果更新成功了,那么这个线程就有用了该对象的锁,并且对象Mark Word的锁标志位更新为(Mark Word中最后的2bit)00,即表示此对象处于轻量级锁定状态,如图:

如果这个更新操作失败:

- JVM会检查当前的

Mark Word中是否存在指向当前线程的栈帧的指针,如果有,说明该锁已经被获取,可以直接调用。(可重入锁) - 如果没有,则说明该锁被其他线程抢占了,如果有两条以上的线程竞争同一个锁,那**轻量级锁就不再有效,直接膨胀为重量级锁(锁膨胀)**,没有获得锁的线程会被阻塞。此时,

锁的标志位为10。Mark Word中存储的时指向重量级锁的指针。

轻量级解锁时:

- 如果有取值为 null 的锁记录,表示有重入,这时重置锁记录,表示重入计数减一

- 锁记录的值不为 null,这时会使用原子的CAS操作将

Displaced Mark Word替换回到对象头中:- 如果成功,则表示没有发生竞争关系,解锁成功

- 如果失败,表示当前锁存在竞争关系。锁就会膨胀成重量级锁,进入重量级锁的解锁流程

6、锁膨胀

如果在尝试加轻量级锁的过程中,CAS 操作无法成功,这时一种情况就是有其它线程为此对象加上了轻量级锁(有竞争),这时需要进行锁膨胀,将轻量级锁变为重量级锁。

1 | static Object obj = new Object(); |

- 当 Thread-1 进行轻量级加锁时,Thread-0 已经对该对象加了轻量级锁

- 这时 Thread-1 加轻量级锁失败,进入锁膨胀流程

- 即为 Object 对象申请 Monitor 锁,让 Object 指向重量级锁地址

- 然后自己进入 Monitor 的 EntryList BLOCKED

- 此时Object的对象头的锁标志为

10。

- 当 Thread-0 退出同步块解锁时,使用 cas 将 Mark Word 的值恢复给对象头,失败。这时会进入重量级解锁流程,即按照 Monitor 地址找到 Monitor 对象,设置 Owner 为 null,唤醒 EntryList 中 BLOCKED 线程

两个线程同时争夺锁,导致锁膨胀的流程图如下:

7、偏向锁

引入背景:

在大多实际环境下,锁不仅不存在多线程竞争,而且总是由同一个线程多次获取,那么在同一个线程反复获取所释放锁中,其中并还没有锁的竞争,那么这样看上去,多次的获取锁和释放锁带来了很多不必要的性能开销和上下文切换。

为了解决这一问题,HotSpot的作者在Java SE 1.6 中对Synchronized进行了优化,引入了偏向锁。当一个线程访问同步块并获取锁时,会在对象头和栈帧中的锁记录里存储锁偏向的线程ID,以后该线程在进入和推出同步块时不需要进行CAS操作来加锁和解锁。只需要简单地测试一下对象头的Mark Word里是否存储着指向当前线程的偏向锁。如果成功,表示线程已经获取到了锁。

1、偏向状态

64 位虚拟机 Mark Word:

1 | |--------------------------------------------------------------------|--------------------| | Mark Word (64 bits) | State | |--------------------------------------------------------------------|--------------------| | unused:25 | hashcode:31 | unused:1 | age:4 | biased_lock:0 | 01 | Normal | |--------------------------------------------------------------------|--------------------| | thread:54 | epoch:2 | unused:1 | age:4 | biased_lock:1 | 01 | Biased | |--------------------------------------------------------------------|--------------------| | ptr_to_lock_record:62 | 00 | Lightweight Locked | |--------------------------------------------------------------------|--------------------| | ptr_to_heavyweight_monitor:62 | 10 | Heavyweight Locked | |--------------------------------------------------------------------|--------------------| |

一个对象创建时:

- 如果开启了偏向锁(默认开启),那么对象创建后,markword 值为 0x05 即最后 3 位为

101,这时它的 thread、epoch、age 都为 0 - 偏向锁是默认是延迟的,不会在程序启动时立即生效,如果想避免延迟,可以加 VM 参数

-XX:BiasedLockingStartupDelay=0来禁用延迟- 注意:处于偏向锁的对象解锁后,线程 id 仍存储于对象头中(54位的threadID)

- 如果没有开启偏向锁,那么对象创建后,markword 值为 0x01 即最后 3 位为

001,这时它的 hashcode、 age 都为 0,第一次用到 hashcode 时才会赋值 - 如果你想禁用偏向锁,添加 VM 参数

-XX:-UseBiasedLocking禁用偏向锁

2、偏向锁的撤销

1、方法一:调用对象的hashCode方法(对象仍可偏向)

- 如果默认开启了偏向锁,但当调用了对象的hashCode方法则会破坏对象的偏向锁

- 正常状态对象一开始是没有 hashCode 的,第一次调用才生成

- 调用了对象的 hashCode,但偏向锁的对象 MarkWord 中存储的是线程 id,如果调用 hashCode 会导致偏向锁被撤销

- 轻量级锁会在锁记录中记录 hashCode

- 重量级锁会在 Monitor 中记录 hashCode

- 偏向锁没有其它记录hashCode的方法,所以调用对象的hashCode会撤销对象的偏向锁

- 在调用 hashCode 后使用偏向锁,记得去掉

-XX:-UseBiasedLocking(禁用偏向锁)

2、方法二:当有其它线程使用偏向锁对象时,会将偏向锁升级为轻量级锁(对象变为不可偏向)

演示代码:(加上了VM参数 -XX:BiasedLockingStartupDelay=0 来禁用延迟)

1 |

|

输出:

1 | 20:48:31.674 c.TestBiased [t1] - 00000000 00000000 00000000 00000000 00000000 00000000 00000000 00000101 |

分析:

- 由于t2线程使用了wait,所以t2需要t1线程的notify唤醒,所以t1线程肯定由于t2线程,得到偏向锁。然后唤醒t2线程后,t2线程去争夺锁,导致了t1线程的偏向锁的破坏,并且t1线程变为不可偏向。

- 第一行:由于禁用延迟,所以t1线程一开始就处于

101的偏向锁,只是此时t1线程还没得到锁,所以它的 thread、epoch、age 都为 0 - 第二行:t1线程拿到了锁,Mark Word记录了当前线程的ThreadID(54位)、epoch(2位)、unused(1位)和age(4位)

- 第三行:t1线程释放了锁,由于t1线程为偏向锁,所以Mark Word依旧记录了t1线程的ThreadID(54位)

- 递四行:t1线程唤醒了t2线程,当此时t2x线程还没有抢夺t1线程的偏向锁,所以Mark Word没变

- 第五行:t2线程抢夺t1的偏向锁,破坏了t1线程的偏向锁,偏向锁膨胀为轻量级锁(Mark Word后三位为

000)- 此时Mark Word记录的是ptr_to_lock_record:62

- 第六行:t2线程释放锁,Mark Word后三位为

001

底层:

偏向锁使用了一种==等待竞争出现才会释放锁==的机制。所以当其他线程尝试获取偏向锁时,持有偏向锁的线程才会释放偏向锁。但是偏向锁的撤销需要等到全局安全点(就是当前线程没有正在执行的字节码)。它会首先暂停拥有偏向锁的线程,然后检查持有偏向锁的线程是否活着。如果线程不处于活动状态,直接将对象头设置为无锁状态。如果线程活着,JVM会遍历栈帧中的锁记录,栈帧中的锁记录和对象头要么偏向于其他线程,要么恢复到无锁状态或者标记对象不适合作为偏向锁。

3、调用 wait/notify

因为 wait/notify(等待唤醒)模式是应用在重量级锁上的,所以调用 wait/notify就意味着此时是重量级锁,而不是偏向锁与轻量级锁。

3、批量重偏向

如果对象虽然被多个线程访问,但没有竞争,这时偏向了线程 T1 的对象仍有机会重新偏向 T2,重偏向会重置对象的 Thread ID

当撤销偏向锁阈值超过 20 次后,jvm 会这样觉得,我是不是偏向错了呢,于是会在给这些对象加锁时重新偏向至加锁线程

1 | private static void test3() throws InterruptedException { |

输出:

1 | [t1] - 0 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 |

注意:

1 | [t2] - 19 00000000 00000000 00000000 00000000 00011111 11110011 11100000 00000101 |

在第20次(从0开始,到19)后,批量重偏向

4、批量撤销

当撤销偏向锁阈值超过 40 次后,jvm 会这样觉得,自己确实偏向错了,根本就不该偏向。于是整个类的所有对象都会变为不可偏向的,新建的对象也是不可偏向的

1 | import lombok.extern.slf4j.Slf4j; |

输出:

- t1线程前面的39个对象全部拥有了偏向锁

- t2线程前19次因为破坏了t1线程对象的偏向锁,升级为轻量级锁

- t2线程从第20次后进入批量重偏向,从第20次到第39次全部都是批量重偏向,t2线程拥有偏向锁

- t3线程的前19个对象为轻量级锁(t2修改为轻量级锁)

- t3线程从第20个对象开始,此时对象的偏向锁是偏向t2线程的,所以t3线程会破坏t2线程的偏向锁,升级为轻量级锁,从第20个到第39个都是这样。

- 由于JVM进行了前39次的偏向锁撤销,在进行第40次撤销操作时,JVM会将整个类的所有对象都会变为不可偏向的,新建的对象也是不可偏向的

- 如果把loopNumber的值修改为38,即只进行38次偏向锁撤销,那么在第39次偏向锁撤销,JVM依旧会采用偏向锁升级为轻量级锁,此时的对象依旧是可偏向的(

101)

8、锁的优缺点对比

| 锁 | 优点 | 缺点 | 使用场景 |